本期要探讨的大问题是:如何让AI具有意识?

别以为这个选题是个科幻选题,这还的确是个科学选题。现在在学术界,确实有门学科叫做机器意识(Machine Consciousness),就是来研究怎么样让机器有意识的。现代人工智能发展的一个底层的动力或者目标就是像人。因为我们想要机器帮我们完成更具有难度的工作,就需要机器变得越来越聪明,越来越智能,而我们人类对智能唯一可参考的对象,就是我们自己,所以就是要让机器像人。经典的图灵测试的底层理念其实就是像人——我们如何判定一台机器有没有智能,就是你和机器交流,你如果不能分辨它是机器还是人,那么我们就说这台机器很智能。

而我们人类不同于万物的地方,就是人有意识,意识让我们具有一种内在的感受,让我们有反思精神,有创新精神,这不单单是会算算术,会解题这种智能了,而是一种更高级的能力。所以,一台有意识的机器,比一台只会搁那儿冰冷无情地执行算法的机器,会更好地发挥它的智能,更好地成为人类的帮手。我们之前有一期大问题讨论过AI机器人伴侣,有人说,机器人伴侣只是机器,它没有灵魂,没有意识,没有主体性,它对我的爱,不是真爱,那我们这一期就来试图讲清楚怎么样让机器人有意识。这样的话,淘宝上买来的爱,就可以是真爱了。

说回来,在说怎么样让AI具有意识问题之前,我们不得不先问一个问题:AI能具有意识吗?就目前而言,我们可以肯定地说,现在AI是有智能的,现在GPT4.0已经比我们大部分人都聪明了,能解题,会作诗,还能画画,现在的AI已经有了相当高的智能了。但是问题在于,有智能就说明有意识吗?

你听了可能会觉得,AI机器人当然可以有意识,我们大部分受过现代科学教育的人都是唯物主义者,当然也可以叫物理主义,叫什么名字不重要,简单理解,就是我们中学课本上说的:“物质决定意识,物质是第一性的,意识是物质世界长期发展的产物,是人脑的机能,是物质世界的主观映象……”意识产生的机制虽然可能很复杂,但就算再复杂,意识也并不是一种神秘莫测的、玄而又玄的东西,它归根结底就是一种物理现象。只要我们把客观存在的物理机制给安排明白了,意识就能从中产生出来。因为毕竟我们人也就是一台机器,只不过是由千百万年的自然选择进化出来的特别复杂的机器,再复杂的机器也还是机器,既然人类这台机器能有意识,理论上,随着科学技术的发展,人造出来的机器当然也是可以具有意识的。

但是,这种唯物主义立场,在哲学家大卫·查尔莫斯的挑战下,遇到了一定的困难。查尔莫斯认为,意识问题并不是像唯物主义者想得那么简单,就是哪怕科技再发展,我们也不一定能制造出一台具有意识的智能机器。为什么这么说?查尔莫斯认为,想要解释清楚什么是意识,要解释两个层面的问题,一是解释简单问题,二是解释困难问题。

意识问题的两个层面

Two kinds of problems

1. 简单问题

The Easy Problems

2. 困难问题

The Hard Problem

所谓简单问题,就是你从唯物主义的角度,解释清楚意识产生的科学机制,包括脑电波放电、信息传递、神经网络、脑皮层的功能模块等等这些通过第三人称的科学描述能够说得清楚的过程。当然,简单问题在技术实现上其实并不简单,现在的脑科学、生物学、物理学还有待进一步的发展,但说它是简单问题,意思是说它在理论上是简单的,就是只要随着物理学、生物学、认知科学各种发展,我们理论上就是能够解释清楚意识形成的机制的,然后我们理论上就可以把这种意识形成的机制应用在AI工程应用上去制造出人造意识。这在理论上都是可行的,因而是简单问题。

但是意识真正困难的点,也就是所谓的困难问题在于,我们从道理上、从理论上,就很难解释清楚意识的一种主观性的层面。这种意识的主观层面也就是一种现象意识(Phenomenal Consciousness),就是我们都能从第一人称视角感受到意识给我们带来的一种主观的感受,就比如你看到一块红色,你会对这块红色的产生一种对这块红色的主观感受,这种主观感受不单单是什么光谱、什么波长刺激你的视觉神经然后传入你的大脑,这种第三人称的科学描述就能完全描述清楚的,这就是一种第一人称的、主观的、不能用科学语言说清楚的感受。

或者说,你嘴里面吃到一颗炝炒西蓝花时候,你对那种味道的感受,这很难用第三人称的语言完全描述清楚,你大概会说:“这是一种很甜很酸、其中还带有一点微微的苦的一种感受。”但你也只能这么说了,哪怕你是一个文学家,你也不可能完全清晰、准确、完备地描述清楚这种主观感受。

再比如疼这种体验,按照脑科学家的解释疼痛就是“C神经纤维被激发了”,但是疼的这种感受很奇妙,它还分为各种各样的疼,它可能是刺痛,是隐隐作痛,是敞开的疼,还是闷着的疼,我去医院跟医生都说不清楚,医生他疼他自己也说不清楚。所以它不能被一句“C神经纤维被激发了”说清楚。

正是由于这种说不清、道不明的现象意识的存在,这就造就了对于意识解释的困难问题。这也就是说,哪怕科学再怎么发达,就算搞清楚了意识产生的各种物理机制,你依然解释不清楚什么是意识,因为这里面永远横亘着一个解释鸿沟(Explanatory Gap),也就是组成我们身体和大脑的各种分子、原子以及它们的各种排列方式,这种第三人称能够描述的、客观的物理过程,怎么就产生了主观的体验了?客观描述和主观体验之间永远横亘着一个解释鸿沟,客观的东西,怎么就能产生主观体验了?这就是意识的困难问题。

这也就是说随着科学技术的发展,我们可以造出非常智能的机器,它又会写论文,又会开车,又会做家务,甚至,我们理论上也可以制造出与真人一样聪明、甚至在行为表现上和人真假难辨的机器,也就是我们常说的通过了图灵测试(Turing Test)的智能机器,但用查尔莫斯的话说,这台超级聪明、超级像人的机器,完全有可能只是一个哲学僵尸(Philosophical Zombie)而已,哲学僵尸就是从外部行为表现上、内部的身体构造上,他看不出和正常人有任何区别,但是哲学僵尸没有灵魂。其实,哲学僵尸正如我们刚刚所说,在关于意识的简单问题方面,他和正常人都是没有区别,行为表现没有异常,并且脑神经搭线都搭对了,脑电波也是走着字的。但是哲学僵尸和正常人唯一的区别就体现在困难问题的方面——哲学僵尸没有主观的意识经验。

所以基于这种意识的困难问题,查尔莫斯认为,我们很难造出一台具有意识的机器,我们造出来的很可能只是一台冰冷无情的哲学僵尸。这就是查尔莫斯的看法,你认同吗?

对于很多持唯物主义立场的哲学家和科学家而言,他们不能认同查尔莫斯的这一挑战。在唯物主义看来,一切问题都是物理问题,都是科学问题,如果我们暂时没能成功地制造出有意识的机器,这只能说明我们在技术上还需要继续努力,但并不是说明它在理论上根本就制造不出来,科学家是做事的人,科学家要推动科学发展,就要大胆假设,并且小心验证,而不是像查尔莫斯那样的哲学家,从逻辑上做推理,从逻辑上发明出什么“意识的难问题”的说法,做出哲学僵尸这种思想实验,提出“机器有没有现象意识,只能由它自己以第一人称才能感知”这样的论调,如果这样的话,人与人之间也没法确定其他人有没有现象意识了,其他人都可能是哲学僵尸,这就陷入了他心问题。

这种问题只是一些哲学家才会想出来的问题,以图灵为代表的一些学者认为,如果问题在人身上也存在,那么人工智能也就不用管它了。如果你依然怀疑一台机器是否具有意识的话,并且如果这种怀疑同样适用于怀疑一个人是不是哲学僵尸的话,那么这份多余的怀疑就可以搁置了。

认知科学家阿尼尔·赛斯认为,我们研究机器意识,不应当陷在无聊的“难问题”,hard problem上,而应当去关注“真问题”,real problem。什么是真问题?就是我们努力地提高我们的知识水平,发展我们的科学知识,把产生意识的各种物理的、生物的机制,也就是查尔莫斯说的简单问题,把这些物理机制一点一点地搞清楚了,那么所谓的“难问题”也就自动消解了。

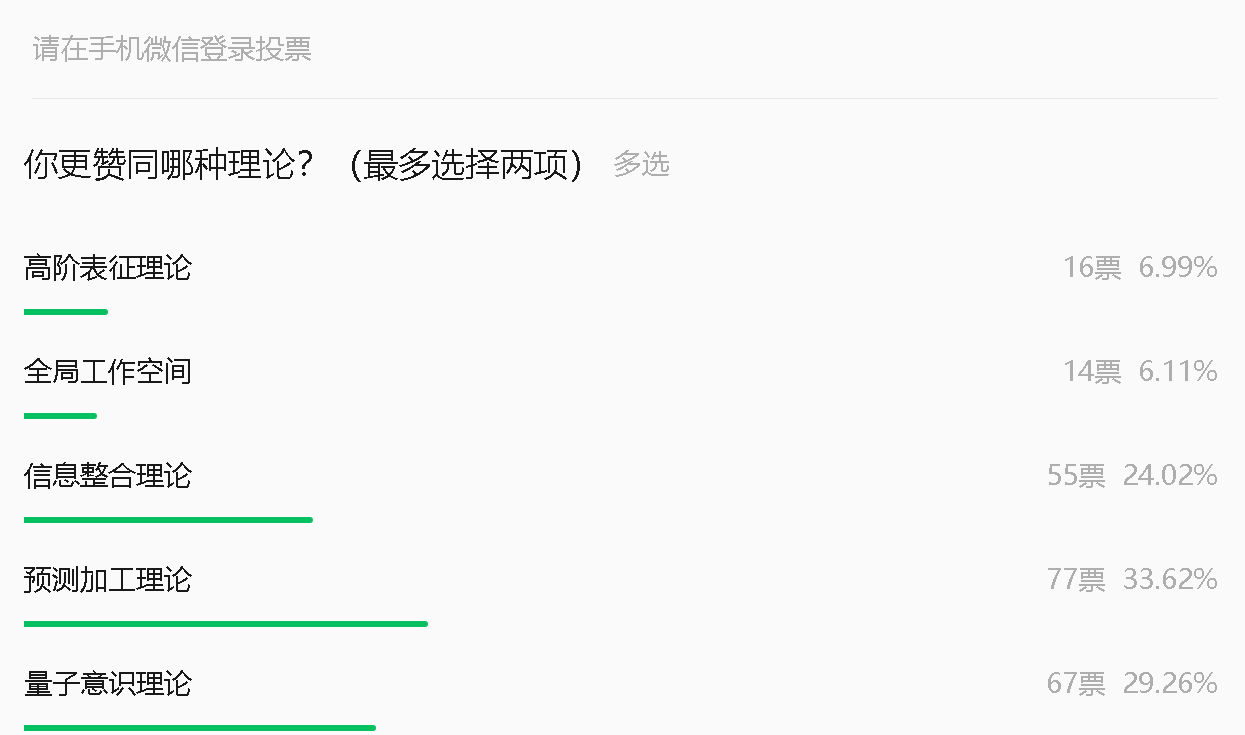

所以本期大问题节目,我们就全员唯物主义,我们就来介绍唯物主义阵营关于意识的解释,我们将会介绍五种在当前认知科学界、心灵哲学界、计算机科学界比较主流的用来解释意识产生机制的科学理论模型。这五种理论模型分别是,高阶表征理论,全局工作空间理论,预测加工理论,整合信息理论,以及量子意识理论。这几种理论哪一种更好地解释了意识产生的机制,目前学界没有公论,这算是学术前沿了,我们这期节目把它们都介绍给咱们大问题节目的观众,最终需要你来评一评,这五种对意识的解释模型,哪一种科学地解释了意识产生的机制,从而能够让查尔莫斯这种“刺头哲学家”闭嘴,并且能在AI工程上有效指导我们制造出有意识的机器。

一、高阶表征理论

Higher-order Representation Theory

高阶表征理论,主要由美国哲学家罗森塞尔提出,高阶表征理论主要是要解释“意识的主观感受是怎么产生的”,也就是现象意识这种第一人称感、这种自我意识的主观感受是怎么产生的。高阶表征理论就是要试图把意识难问题解释掉。

高阶表征理论一句话简单说就是,现象意识不单单是我们感知到环境中的某些个事物,而且是我们感知到了我们对事物的感知。

高阶表征理论里的“表征”(Representation)是什么意思?简单理解,就是我们的大脑接受到了外界环境的信息,对这些信息进行表示和处理,这就是表征。在此基础上,罗森塞尔区分了两种表征,一阶表征和高阶表征。

对信息的两种表征

Two kinds of representation

1. 一阶表征

First-order representation

2. 高阶表征

Higher-order representation

一阶表征就是我接受到了环境中的某些信息了,比如说,我看到了一朵红色的话,花的颜色、形状、气味的信息进入了我的大脑了,这就是我对这朵花产生了一阶表征。但是,即便我产生了这些一阶表征了,这并不能说我意识到了这里有一朵红花。比如说,我看到了我家阳台上盆栽里那朵红色的花,我眼睛明明是睁着的,我明明看到了,但我对这朵花习以为常了,我根本就没过脑子,那这就不叫我对这朵花产生了意识。

一阶表征构不成意识,构成意识的关键在于,对一阶表征的再次表征,也就是高阶表征。比如说,我看到一朵红色的花,不仅仅是我的大脑和身体接收到了关于花的颜色、形状和气味的信息,而且我还意识到了我接受到了这些信息。换句话说,我不仅看到了花,还意识了到我看到了花。高阶意识理论认为,这种对信息处理过程的“二次意识”,也就是意识到自己意识到了某个东西,这才是意识的关键。

所以,如果要产生意识,这里面必须要有个嵌套结构。也就是说,虽然有了一阶表征,但一阶表征如果没有被主体所觉知,主体依然是无意识的,而只有当一阶表征被主体觉知的时候,意识就产生了。人的自我感,对各种体验的感受,各种自觉的认知,由此就产生了。我们总说,意识是一种自觉,是我对我的感知的再感知,正因为有这种高阶的结构,这种反思的结构,才会产生一种自我感,产生一种主观的感受。

这种高阶表征理论解释了很多心理学上研究的现象,比如说刚刚提到的,我明明看到了我家阳台上的一朵花,但我却没有意识到,这种现象在心理学里面叫做“注意盲视”(Inattentional Blindness),一个经典的实验案例就是“看不见的大猩猩”,就是实验人员让被试观看一个视频,视频里面几个人在互相传球,被试被要求记下里面的人互相传球的次数,而实际上,在传球的过程中有一个大猩猩大摇大摆地从其中走过,但是有很大一部分被试事后表示自己并没有看到大猩猩。如果用高阶表征理论来解释,就是虽然大猩猩进入了被试的一阶表征,但一阶表征不是意识,除非你对一阶表征进行再表征,这才会产生意识。

我们知道了人的意识产生于一种高阶表征,那么我们据此在AI工程方面,怎么制造出人工意识?其实,已经有一些科学家和工程师在方向努力了。关键问题就在于,需要给机器模拟出自我意识,也就是让机器能够模拟对自身状态的认知,这就需要给机器建构出多层嵌套的表征结构。一阶感知是指对外部世界的直接感知,高阶是对机器人内部世界的感知。

比如说,巴勒莫大学机器人实验室的Chella教授等人构建了一种基于高阶感知回路的机器人感知信息处理系统,并开发了一个博物馆导游机器人Cicerobot。Cicerobot的高阶反思能力是通过机器人内部的三个部分实现的:亚概念感知部分、语言处理部分和高阶概念部分。通过这些部分的相互作用,Cicerobot能够对外部事物进行心理表征,并在内部模拟外部环境。这种高阶感知回路的结构使得Cicerobot具有一定自我反思的能力,这使得Cicerobot能够执行一些复杂的任务,比如在迷宫中导航,同时展现出自我意识的某些方面,例如对自身状态的感知和对环境的适应性行为。

另外,乔治梅森大学的Samsonovich教授的团队开发的一个具有自我意识的仿生认知系统GMU-BICA,也是包含高阶的认知表征和低阶的图式表征,在认知系统中定义的心理状态不但包含内容,还包含主观观察者,因此系统拥有了一定的自我意识。

介绍完高阶表征理论,我们再来介绍一下对这个理论的批评,这个理论的缺点主要体现在,这个理论难免会面临算法上的递归或者无穷倒退的难题。而且,在解释意识方面,高阶表征理论比起下面要介绍的其他理论,更多有的是计算机科学方面的支持,但缺乏脑神经科学方面的支持。

二、全局工作空间

Global Workspace Theory

全局工作空间理论应该说是目前影响力相对最大的一个对意识解释的理论模型,它是由心理学家伯纳德·巴尔斯提出的,巴尔斯将大脑看做是由神经元组成的计算机,但和现有计算机不同,大脑并没有一个负责发号命令的中央处理器,而是由各种功能各异的分布式的进程模块组成的,有的负责语言,有的负责记忆,有的负责听觉、有的负责视觉等等各种认知功能模块等等,这其中没有统一的指挥。

这些不同的功能模块一直在后台运行着,它们是无意识的。就比如说之前举过的例子,我看到我家阳台上的一朵红色的花,明明接受到这些视觉、嗅觉的信息了,但没过脑子,没产生意识,还包括你进行人脸识别的时候也是无意识的,你不会刻意地去辨认。或者你在干一件特别熟练的事情,比如一个钢琴家在弹钢琴的时候,手指的运动也是无意识的。

那什么情况下才会产生意识?答案是,当这些无意识的功能模块进入了全局工作空间的时候,就产生意识了。那什么是全局工作空间,巴尔斯用了“剧场的比喻”来解释全局工作空间理论的:我们的心灵就是一座剧场,全局工作空间就相当于是被聚光灯照亮的舞台,注意力就是舞台的聚光灯,被聚光灯照亮的部分,也就是能被所有观众看到的演员们正在上演的戏码,这就是我们意识到的内容。形成意识体验的各种意识语境就相当于导演、编剧、道具师等幕后工作人员。而剧场里没有被聚光灯照到的黑暗的部分,也就是台下的观众,就是无意识的,台下的观众就是之前说的负责各种功能的认知模块,他们看到台上被照亮的内容,所有的观众们就知道舞台上正在上演什么戏码了,但是台下的观众不单单仅仅只是做观众,他们也是潜在的演员,他们时刻准备着登台参与表演,也会被聚光灯照到。这一个或这几个认知功能模块的运作被聚光灯照到,从而就进入了全局工作空间,于是它们的运作就被广播了,就被剧场里的全部观众都看到了,这种被全局都看到的状况就是意识。

全局工作空间理论不只是一个文学比喻,它在心理学和神经科学中是有科学基础的。在幕后的这些认知系统,也就是导演、编剧、道具师等幕后工作人员,对应于心理学所讲的“语境”,舞台下的观众席对应于无意识的内容,舞台上被照亮的部分对应于意识的内容,舞台上未被照亮的其余部分对应于认知科学讲的即时工作记忆(working memory)。这些在实证科学中都是能对得上的。

我们再换个类比,我们可以把大脑比作一个多党派轮流执政的政体,大脑里面没有一个大皇帝或者大总统,也就是没有中央处理器,而是多党制组成的议会,这议会里面的各个党派,有的擅长搞经济,有的擅长搞民生,有的擅长搞教育,有的擅长搞外交。它们平日里都是私底下默默地搞各自的工作,但是议会里面有个主席台,主席台也就是全局工作空间,各个党派之间是或者轮流着,或者竞争着,做轮值主席,一旦轮到那个党派上主席台了,它搞的事情整个议会就都知道了。比如说擅长搞民生的党派上台了,这时候大家都知道了,我们现在在大搞特搞民生工作,并且轮值主席的党派,还能影响其它在野的党派,组成临时政府,比如拽一些擅长搞教育的党派的人也上主席台,让他们在搞教育的时候,顺带着多给贫困子弟减免减免学费之类的。当然,轮值主席干不了多久就会被轮下去,换其他的党派上主席台。

这里擅长不同工作的党派,就相当于负责不同认知功能的模块,那如果上了主席台,那就是有意识的,那如果没上主席台,你在台下的运作就是无意识的。全局工作空间理论再简单点说,就是一种心理状态如果是局域分布的,那么它就是无意识的,如果是全局分布的,它就是有意识的。

所以,当我们有意识地去进行的认知和行动都感觉有一种全局性,也就是能调动起我们各个认知和行动的功能模块团结一致地采取一种连贯的行动,比如说,你在公园里散步,这时候,你的视觉系统可能会看到一只猫,听觉系统会听到喵喵叫,而运动系统可能会准备伸手去摸它。你不会只是意识到单一的猫的形状,或者只是单一的听到猫叫,这种零散的、局域性的信息,而是这些视觉、听觉、运动的信息会被送到全局工作空间,被广播出来,从而形成一个你自己能够自觉意识到的完整的、连贯的体验——你在公园里发现一只正在喵喵叫的猫,并且你准备伸手去摸它。

后来的法国脑科学家斯坦尼斯拉斯·迪昂对全局工作空间进行了神经建模,把这些认知模块进一步具体化为专门化的神经回路,进一步提出了全局神经工作空间理论(Global Neuronal Workspace Theory),这其中的神经回路模块可以通过脑成像以及神经生理学来观测与证实。所以这就是一个可测量、可证伪的科学理论。

根据全局工作空间理论对意识的解释,我们据此在AI工程方面,怎么制造出人工意识?关键就在于,多模块分布式处理,并且在多模块之间建立一个全局工作空间。巴尔斯的全局工作空间理论很快就引起了斯坦·富兰克林等多位人工智能科学家的关注,并将其发展出“分布式智能自主体”,IDA(Intelligent Distributed Agent)以及后来的升级版LIDA这样的意识神经计算模型。这种神经计算模型由并行处理的多主体来实现,各主体通过系统提供的全局工作空间进行相互通信,系统在面对各种情况下能够瞬间做出行为决策。这种依据全局工作空间意识理论的建构的计算系统目前仍在进化迭代之中,目标就是模拟出和人类等效的意识。

最后再来介绍对这个理论的批判,它的缺点主要体现在,它在哲学上没有很好地直面应对查尔莫斯提出的意识的难的问题,也就是意识的主观性怎么解释,全局工作空间没有很好地应对。当然,它也可以一屁股坐在一个强硬的唯物主义立场上,认为意识的主观性就是个假问题,我们只需要关注所谓的意识的“简单问题”就够了,反正就是物质决定意识,物质结构对了,意识的主观性自然就产生了。

三、信息整合理论

Intergrated Information Theory

信息整合理论是最近这几年比较火的理论,它是由意大利神经科学家朱利奥·托诺尼提出的,托诺尼提出的这套信息整合理论是一个非常数学化的理论,很多数学公式和数学推演,但是意思简单说就是,意识的本质就是信息,意识产生于认知系统对大量信息的整合,信息整合程度高的系统就能产生意识。

信息整合理论有个两个关键点,一是分化,二是整合。分化就是说,认知系统是有多个不同的部分构成的,比如我们的大脑里不同的神经回路模块做不同的事情,起到不同的功能,所以是分化的。分化就说明了系统的信息量是高的,如果所有的模块都干同一件事情的话,这样的信息量就不高。

然而,单单是信息量高并不能产生意识,比如说当我们的大脑被麻醉的时候,各个不同的脑区都很活跃,信息量很高,但是互相之间信息整合的程度很低,属于是一盘散沙的状态,因而麻醉状态中的大脑也就没有意识觉知状态,因此要产生意识还需要一个关键,就是这些分化的不同模块之间又是高度整合的,不同的模块之间的信息交流是非常密切的,这些不同的部分之间组成了一个整体的系统,整体的系统又是单一的、整体性的、不可分割的。比如说你麻醉药效过去以后,回到清醒状态,那这时候你的各个不同脑区开始互相传递信息了,前额叶皮层与各个脑区之间都存在着远距离的连接,这时候你就产生意识了。

所以,什么是意识,意识就是既高度分化,因而具有高度的信息量,又被整合成了一个单一的、整体的认知系统,这就会产生意识。意识就是一种各个部分整合在一起形成了一个整体的系统,从而实现了一种整体大于部分之和的效果。也就是说,意识是各个部分整合在一起所产生的一种涌现现象。

托诺尼用了一个量化的数值,也就是希腊字母Φ,用来计算一个系统的信息整合程度。Φ值简单说就是一个系统作为一个整体的信息量。Φ值是大于系统的各个部分的信息量的简单相加的,这就是刚刚说的整体大于部分之和的一种涌现现象。

Φ既然是一个数值,它就不是非此即彼的关系,而是可大可小的,意识水平是一个渐变的光谱。所以,一个认知系统的Φ值除非是0,那它的Φ值越高,说明认知系统的意识越强。

根据信息整合理论,意识产生于各个部分的信息整合,这其实也就解释了,我们人的脑子里面各个区域虽然各干各的功能,但在我们清醒的时候,我们的意识不会有割裂感,我是有一个统一的“我”以及统一的世界的体验,比如说,我们左眼和右眼看到的东西是不一样的,你自己依次轮流闭上一只眼就会发现左眼和右眼看到的画面是不一样的,但是我们两只眼睛都睁开的时候,我们看到的画面不会觉得不和谐,感觉看到的就是同一个和谐的世界,那是因为大脑最终会将左右眼分别看到的画面整合为一副完整的意识画面,这就是大脑信息整合的功能。

著名的裂脑(Split-Brain)实验也映证了信息整合理论,这个实验还是获得诺贝尔奖的,我们都知道,大脑分左半脑和右半脑,你左眼看到的东西会报告给右脑,右眼看到的东西会报告给左脑,左脑是负责语言和逻辑思维功能的,而右脑是负责空间和形象感知功能的,两个半脑之间通过胼胝体进行神经连接并且互相传递信号的。研究人员发现,那些胼胝体被切除的人,他的意识是割裂的,甚至是混乱的。比如研究人员把他的右眼蒙上,给他的左眼,也就是右脑看到一个东西,比如说,看到一个杯子,但是他说不出来这是什么东西,他的语言功能没有丧失,还是能说话的,只不过他说不出来此时只有右脑看到的东西,因为左脑是负责语言功能的,此时右脑无法把信息传递给左脑,这时候他会乱说,或者顾左右而言它。这就说明,如果两个半脑的信息没有整合起来,人的意识就是割裂的、混乱的。

信息整合理论还能解释动物意识,动物有没有意识,就看它各个脑区的分化和整合程度强不强,也就是看Φ值,我们对动物的大脑进行扫描,发现动物的脑神经系统分化状态比我们人类要少,也就是信息量不高,所以动物的意识水平要低于人类。

那么关于信息整理理论对意识的解释,怎么样应用到制造人工意识的AI工程上,一个关键的要点就是,提高信息整合度,其实也就是想办法提升系统的Φ值,一台机器如果它的Φ值接近了人类,那我们就可以说它具有了类似于人类的意识。当然,这目前在技术上实现起来还有一段路要走,因为我们人类的Φ值是非常非常高的,当然,现在对于人脑的Φ值具体怎么算还在争议之中,但肯定是非常高的,我们人脑的神经元数量就有将近1000亿个,彼此之间还是互相连接的,那Φ值可想而知就是个天文数字了。

最近这一年爆发的ChatGPT,为什么GPT这种大语言模型(Large Language Model)这么聪明?关键词就是——大!它的特点就是规模庞大,一个模型能包含数十亿的参数,大就是不一样,大就会涌现出新东西。

也许有人会说信息整合理论和之前介绍的全局工作空间理论有点像,都是强调了信息在整体或者全局的传播,但是它俩之间还是很不一样的,第一,信息整合理论强调的是信息的整合程度,意识是各个部分组成一个整体之后的涌现,而全局工作空间强调的是某一个或几个模块的信息在全局的共享和广播。

第二,更重要的,全局工作空间理论可以说是一个比较唯物主义的理论,讲求物质决定意识,但信息整合理论就有点泛心论(Panpsychism)的倾向了。泛心论大概有点万物有灵的意思,不过不是那种原始宗教式的相信一草一木皆有一种人格化的灵魂,而是说万事万物是物质的,但同时,也有精神的属性。不仅我们人类有意识,动物也有意识,而且,一张桌子,一块石头也是有意识的。这倒也不是说一块石头也有和我们人类一样的意识,但是至少也可以说,石头也有着意识的微弱迹象的,意识就是对信息的整合,那石头系统也是一种对信息的整合,只不过石头系统的Φ值比较低。所以,我们当然可以说,一部智能手机比一块石头更有意识。

当然,这种泛心论的倾向也是信息整合理论遭人批评最多的地方,石头也有意识,智能手机也有意识,这不符合直觉。当然,对于这一点,提出意识难问题的查尔莫斯倒是蛮喜欢信息整合理论的这种泛心论的倾向的,任何与强硬唯物主义有出入的意识学说,查尔莫斯都喜欢。查尔莫斯自己也提出过一个说法:物质和意识都不是最底层的,最底层的东西是信息。信息就是比特,也就是一种计算过程,就是1001000111,就是代码,就是算法。查尔莫斯提出的这种信息本体论我们在之前一期反驳虚拟世界论证的大问题节目里面介绍过的,放在今天的语境中说,我们会发现,查尔莫斯的这种“信息本体论”和托诺尼的信息整合理论有相通的地方——一切都是信息,信息决定了物质,信息也决定了意识。

四、预测加工理论

Predictive Processing Theory

预测加工理论(Predictive Processing Theory)也叫做预测编码理论(Predictive Coding Theory),是最近这几年比较新的一个关于意识的理论,它的代表人物有认知科学家阿尼尔·赛斯以及认知哲学家安迪·克拉克等人。理论和之前介绍的几个理论不同的地方在于,之前介绍的几个理论都承认,意识是实实在在的,我们都能以第一人称的感知,实实在在地感知到我自己是有意识的。但是,预测加工理论告诉我们,意识并不是实在的,我们所感知到的自己是有意识的,这其实是一种幻觉。

英国认知科学家阿尼尔·赛斯把这种意识错觉叫做“受控的幻觉”(Controlled Hallucination)——我们的大脑并不是被动地接收外部世界的信息,而是主动地构建我们所感知的现实。比如说,我们看到一块红色的画作,我们心中产生了一种不能言明的关于红色的主观感受,这种感受并不是来自于这幅红色的画这个对象本身,对象本身只是散发出了一系列诸如分子,原子,光子,波长这些信息,这些信息跟红色没有任何关系,而这种关于红色的感受意识,只是我们自己建构出来的一种错觉,这种错觉为的是编织出一个标签,或者一个故事,准确说是一个模型,来预测或者猜测我们接受到的信息是个这么个东西。而这种猜测或者预测本身只是一种幻觉。

赛斯在他的新书《意识机器》里面也举了那个著名的例子,前几年大家都在网上争论有一张图,也就是“蓝黑白金裙”到底是白金相间的颜色,还是蓝黑相间的颜色。据此分成了两派,谁也说服不了谁。问题的关键并不在于图片中的裙子本身是什么颜色,而你的预测模型首先是把这张照片脑补出是在户外拍的,还是在室内拍的。如果你默认是在室内拍摄的,由于室内的光偏暖,所以你就会自动脑补,大脑自动给裙子自动调色温,你就会把裙子看做是蓝黑色。如果你默认是在户外拍摄的,户外的光偏冷,你就会自动脑补这条裙子是白金色的。这条裙子到底是蓝黑色还是白金色取决于你主观的解读,你意识到你看到什么样的颜色是你主观脑补、主观解读出来的。

我们建构出意识这种幻觉,并不是我们心灵中的认知模型先接收到到了外部的信息输入,然后我们认知模型去接受它,而是反过来,我们先有一套预测模型,然后拿外部的信息故意往模型里面去套。意识并非是由外向内的信号流,而是由内向外(Inside-Out)的信号流。世界是我们脑补出来的。

其实,这一思想早在18世纪的德国哲学家康德那里就已经提出来了。康德认为,我们对世界的认识,并不是我们的认知系统去符合外在的认知对象,而是反过来,外在的认知对象来符合我们的认知形式,这才能够产生认识。这就是著名的认识论上的“哥白尼式的倒转”。同样的道理,按照预测加工理论,并不是我们的心灵对外部的客观现实的如实登记,而是反过来,是我们的认知模型,主动地去建构和预测所谓的“外部现实”。比如说,你在公园散步,这时候,你看到前方有一团白色的毛茸茸的东西,你立马就预测,这是一只猫。实际情况并不是:你观察半天,仔细观测,还绕到它背面一看,它有猫的眼睛,也有猫的四只脚,然后你才判断这是一只猫。而是你从一开始先有猫的预测模型、猫的标签,然后,把接收到的视觉听觉信息,立刻打上标签了:“我意识到了一只猫”。

至于猫认知对象本身是什么样的,这不重要,从外界传输给我们的信号都是一团混沌,都是波长,原子,分子,光子,根本没有什么「猫」、「白色」、「红色」这样的标签,这些标签是我们自己脑补出来的预测模型,至于脱离了我们的脑补,世界本身是什么样的,这是我们永远无法认知的,用康德的话说,世界本身就是物自体(Ding an sich),物自体是不可认知的,我们能认识到的都是幻觉。

也许有人会担忧,如果我们的意识只是一种幻觉,那我们不就是活在楚门的世界,或者活在黑客帝国的matrix之中了?那这样太糟糕了。对于这种担忧,预测加工理论会说,虽然是幻觉,但它是有用的幻觉,它有利于我们的生存与繁衍。

意识这种幻觉在进化论意义上是有适应性的,这种幻觉有利于我们对外界环境做出主动的预测,并做出合适的行为,从而有利于我们寻找食物,躲避天敌,寻觅配偶。比如我虽然不知道一块烧红了的铁本身是什么,但我能预测它很烫,于是我就别摸它;我看到狮子,我预测它会咬人,于是我们躲开;看到美丽的异性,我们预测跟他在一起会很快乐,于是我们展开追求。进化并不要求我们关心世界本身是什么样的,进化只要求我们能够繁衍后代。

而且,进化讲求够用就行,自然选择并不是要把我们一个个都打造成科学家或者哲学家,让我们对世界的现象和本质都进化出深刻的认识,自然选择并没有要求。要知道,人脑的能耗是非常高的,人脑的质量占全身总质量的2%,而能耗却占了全身总能耗的20%,现在我们的脑子已经能耗这么高了,再高就不划算了。做数学题、做逻辑推理是很费脑子的,自然进化并不会让我们喜欢做数学题,为的就是节省脑力。

有个段子说有三个学者坐火车第一次来到苏格兰,他们透过火车车窗看到了一只黑色的羊,文学家说:“哇,苏格兰的羊都是黑色的!”科学家说:“错,你只能说,在苏格兰,有一只羊是黑色的。”逻辑学家说:“错,你只能说,在苏格兰,存在着一只羊,它朝向火车的这一面是黑色的。”这个段子本来是说逻辑学家的思维特别缜密,但是,按照预测加工理论,我们的认知系统的运行模式恰恰不是像一个逻辑学家那样成天做逻辑推理,采用这种高能耗的模式,而就是像文学家和科学家那样,先抛出个大概的说法就好。进化并不要求我们什么事情都具体情况具体分析,而是给我们打造了预测模型这样的快捷方式,所以我们就可以把预测模型这种快捷方式理解为认知套路,套路就是不动脑子,直接走个流程,凭直觉直接下判断,直接把外界信息往我们的认知套路里面硬套。

那于是又有人问了,如果都是这种不过脑子,直接拿预测模型这种套路去硬套,那套不上怎么办?凭直觉下判断如果错了?那我们的预测模型这种快捷方式不就不利于我们的生存繁衍了?

不是这样的,虽说预测模型是套路,但套路是可以调整迭代的,它迭代的过程就是一种贝叶斯推理(Bayesian Inference)的过程,简单说就是根据收集到的新信息,不断修改调整我们已有的信念。这里的信念指的就是我们已有的预测模型,收集到的新信息尤其是指错误信息,也就是和我们已有的预测模型不符的地方,比如说,我们一开始的预测模型是默认羊的左半边和右半边的颜色大概率都是一样的,所以我们就像那个文学家或者科学家一样,看到羊的半边是黑色,就自动脑补它全身都是黑色的,但是如果有一天,羊基因突变了,出现了好多只一面黑一面白的羊,由于碰壁碰多了,到时候我们的预测模型就会迭代。

总之,核心精神就是,你先有一个先验的预测模型,然后根据收集到的新信息调整迭代你的预测模型,最终使得你的预测模型这种认知套路和外界输入的信息能够完全套得上。用术语说,贝叶斯过程追求的目标就是自由能最小化(Free Energy Principle),也就是减小大脑里面的系统不确定性,最小化我们预测模型的预测误差,要把自己的套路训练得能和外界信息完全套上。

这也就像现在的神经网络机器学习,我们一开始都是给神经网络随机设置一些权重参数,然后再慢慢训练,调整修改权重参数,然后你随便输入一张猫的图片,机器立马就能识别出来。我们人的预测模型也是在经验生活中不断地修正、调整的。

那有人就要问了,机器学习的参数一开始是随机设置的,那我们人一开始在出厂的时候,有没有出厂就自带的、不是随机设置的认知模型?有的,人是自带出场设置的,当然,这是进化来的,然后通过遗传,我们不用后天学习就已经具备的先天知识。科学家对刚出生不久的小婴儿的研究,发现小婴儿已经具有的另一些不是后天学习来的先天知识,比如说怕高,比如说怕蛇,以及一些所谓的朴素物理学(Naïve Physics)的知识,比如一个东西会占据一定的空间,并且每次只会占据同一个空间,而不会同时出现在两个地方,也不会突然消失等,这些先天知识都是通过遗传而预装在我们心灵中的知识。

那预测加工理论怎么解释人的意识里面那种自我感,也就是那种第一人称的、主观的自我意识?按照预测加工理论,自我意识的产生就是我们时时刻刻都在自动脑补、预测环境信息和我们的行动,并且我们也时时刻刻都在接受外界信息给我们的反馈,于是,这就形成了一种时时刻刻都在持续进行的预测-反馈的循环,这种循环一直在转着,我们就产生了一种对自己的持续的掌控感,这种掌控感也就是自我意识的来源。

另外,在人际和社会层面也是同样的道理,“我是谁”也取决于我自己主观的预测模型,也就是我自己讲给自己的一套故事,这也就是我对我自己的预测模型。比如说,我给我自己讲的故事是“我是一个大帅哥”,我相信这一套自我叙事,以后我跟人打交道的时候,我就拿着这套自我叙事去和别人打交道,我就会仗着自己的美貌积极主动,主动要求大家来点赞投币一键三连。但是,这一套预测模型也是要进行贝叶斯式的反馈调整的,比如说,我自己觉得自己是个大帅哥,但我跟人打交道的时候,收到的反馈其实并不能自圆其说,我说一键三连,别人总说下次一定,我就会碰壁,就会被别人说是普信男,别人就不喜欢我了,那我多次得到这样的反馈,我就会修改我对自己的预测模型,要么就是我开始告诉自己我其实长得并不美,要么我告诉自己我有一种难以被人察觉的美丽,总之无论怎样我就要调整预测模型。

这就是预测加工理论对自我意识产生给的解释。就是这套预测和反馈的机制,这套编码、这套叙事、这套幻觉,一直持续下去,循环往复,这就形成了你的意识。

其实,预测加工理论,会给我们的生活带来一些启示,第一,人是能学习的,我们虽然会有各自不同的出厂设置,比如每个人天生的智商可能是高低不同的,或者童年的不幸经历会影响一个人的性格,但是,我们是可以学习的,我已有的预测模型并不是不可改变的,我们是能够通过学习改变我们已有的预测模型的。第二点启示,既然我们对世界的认识是一种受控的幻觉,是我们主观的建构,我们在某种意义上就可以通过改变自己的预测模型来改变我们的生活。古罗马的哲学流派斯多葛主义教导我们,我们不一定能够改变世界本身,但是我们能够改变我们对世界的看法。这倒不是说我们要发挥阿Q精神,而是让我们在生活中要看开点,有时候你被一些负面情绪所绑架,不是世界本身对你犯的错,而是你自己跟自己过不去。

根据预测加工理论,在机器意识的工程应用方面,我们怎么制造出人工意识?其实,就是把预测-反馈-预测-反馈的不断迭代调整的算法加入到机器学习之中,最终使得预测模型的预测误差不断减小。比如说,罗切斯特理工学院的Alexander Ororbia和宾夕法尼亚州立大学的Daniel Kifer,在2022年的论文中,基于预测编码理论,提出了一套更接近于人脑学习机制的机器学习算法,叫做神经生成编码(NGC)。我们都知道,传统的神经网络深度学习算法是基于“误差反向传播”算法来进行训练,来调整各个神经元之间的连接的权重的,但这种误差反向传播的算法,其实并不是我们人脑的运作模式,而且,依靠误差反向传播进行权重调整要依赖于全局的误差信号传递,它不会进行局部的调整,而在NGC中,神经元通过局部误差信号进行学习和调整,局部的神经元预测另一个局部的神经元状态,并根据预测与观察信号差异来调整其局部模型的参数。实验结果表明,NGC架构比传统的神经网络深度学习更加灵活和高效。

对这个理论的批判,其中主要的一点就是对之前提到的自由能最小化原则的批判,也就是所谓的黑暗房间问题(Dark Room Problem)。之前说的自由能最小化原则就是追求消除预测误差,追求我们的认知套路和外界信息能够完全套得上。那么问题就来了,消除预测误差是目标,那么我们最终会演化到一个没有任何意外的状态,这就类似于处在一个完全黑暗的房间里面,我们就不会遭遇到任何新的信息,没有输入就没有误差了,躺平是永远不会出错的。但是,这种状况并不符合我们的实际行为,因为我们通常会给自己制造出一些不确定性,我们会寻求新的经验,而且环境的改变也必然会造成新经验,而不是停留在一个完全可预测的环境中。

五、量子意识理论

Quantum Consciousness

如前所述,本期节目介绍的几种对意识的解释的理论,总体都属于唯物主义阵营,也就是说,物质决定意识,意识是物质派生出来的,这种唯物主义也可以叫做物理主义,也就是意识现象归根结底是一种物理现象。这里要介绍的量子意识理论也算是物理主义的,但是量子意识理论认为前面的物理主义都是错的,因为前面的物理主义都是建立在经典物理学的基础之上的,而经典物理学并不能解释意识的产生,意识产生的机制是一种量子力学机制。

量子意识理论是一个名气很大但在学界内有很多争议的理论,因为量子力学本身就是一个比较玄的学问,正所谓,遇事不决,量子力学,爱因斯坦来了也得懵圈。对量子力学的解释就很难解释清楚,现在主流的对量子力学的解释就是以物理学家玻尔、海森堡等为代表的哥本哈根学派主张的哥本哈根解释(Copenhagen Interpretation),所谓的哥本哈根解释,也就是哥本哈根不解释,这一派的口号就是Shut up and calculate!(闭嘴,计算!)也就是别扯什么量子力学的物理学内涵、哲学内涵,量子力学并不反应世界的本质,你就冰冷无情地算算术,解薛定谔方程就好了,除此以外,量子力学没什么内涵。就连量子力学本身说明了什么意思,这都说不出有什么意思,你拿量子力学本身就挺玄的东西,来解释意识这么一个更玄的东西,这更是玄学配玄学,玄而又玄。

用量子力学来解释意识的一个代表人物就是著名的物理学家、2020年诺贝尔物理学奖得主罗杰·彭罗斯,彭罗斯认为,意识的产生机制就是一种量子力学机制。对意识的解释,怎么就能扯上量子力学?为了解释这个事情,我们还是得先科普一下量子力学。

我们都知道,按照经典力学理论,一个物理粒子,无论是光子还是电子,它就像一个小球一样的,和宏观物体一样都符合机械力学原理,都占据一定空间,在空间里面碰来碰去,这就造成了物质的运动。但是量子力学告诉我们,在微观世界不是这样的。我们知道,在微观世界,物理粒子具有一种所谓的波粒二象性,也就是说,在微观层面,本来应当像小球一样的粒子却具有了波动性,会呈现出一种像波动的云一样的状态,这也就是所谓的量子的叠加态。

我们都知道著名的双缝实验,有左右两条缝可以让一个粒子穿过,按照宏观世界的道理,粒子是要么走左边这条路,要么走右边这条路,表现为小球一样的粒子态,但是实验发现,粒子是既走了左边这条路又走了右边那条路,它自己和自己发生了干涉。也就是说,两条路,一个粒子同时都走了,这就很奇怪了。

那你会说,这没什么奇怪的,在微观层面,粒子具有波动性,那波就是可以既走这条路又走那条路的。可是并非如此简单,实验发现,你不观测粒子的时候,它确实是既左又右的,处于一种叠加态,但是奇怪的地方在于,你一旦观测,波顿时就坍缩了,它就从一种既左又右的叠加态,顿时坍缩成了要么走左,要么走右的确定态了。当然,到底坍缩成左还是右是完全随机的,这就是量子力学里面的真随机现象。从叠加态坍缩成确定态,在薛定谔方程里面的表现就是波函数的坍缩,问题就在于,波函数怎么就坍缩了?一个处于叠加态的既左又右的波,怎么就由于人的观测,莫名其妙地坍缩成了一个确定的粒子了?

当然,按照哥本哈根不解释这种躺平策略——别问,问就是遇事不决,量子力学,你就算算术就行了。在薛定谔方程里面,波函数的坍缩是不确定的,它会解出一个概率值。你听听看,概率,这让很多物理学家感受到奇耻大辱,包括爱因斯坦也受不了。按照爱因斯坦等物理学家的看法,物理学是研究丁是丁卯是卯的确定性的学问的,我们算算术必然会算出一个确定的数学解,如果只解出了一个概率,那物理学还是物理学吗?

所以,面对哥本哈根不解释,也有很多物理学家试图对波函数坍缩进行解释。其中,最著名的一个思想实验就是“薛定谔的猫”(Schrödinger’s Cat)。提出薛定谔方程的物理学家薛定谔就试图来解释叠加态的坍缩究竟是怎样一种情况,他设想把一只猫和一个量子装置放在一个箱子里面,这个量子装置就是一个放射性原子和一瓶毒药。我们知道,放射性的原子是否发生衰变就是一个量子随机事件。如果箱子里的原子衰变了,就会触发一个机关,毒药瓶就会被打碎,毒药就会把猫给毒死,如果原子没衰变,就不会触发机关,猫就还活着。

放射性原子是否衰变是一个量子随机事件,因此放射性原子就处于一种量子叠加态,就是既衰变又没衰变,那么关联到这只猫,这只猫也就处于一种叠加态之中,在我们打开箱子观测这只猫之前,这只猫处于一种既死又活的叠加态。注意,是既死又活,不是要么死要么活。那问题就来了,一只猫怎么可能处于既死又活的状态呢?

当然,薛定谔当初提出思想实验是为了反驳哥本哈根解释的,因为哥本哈根不解释认为,在波函数坍缩之前,粒子就是处于一种既这又那的叠加态,叠加态就是叠加态,不要问为什么,反正就是叠加态。薛定谔做思想实验就是为了嘲讽哥本哈根解释,什么叫既这又那的叠加态?这很荒唐,就像这只箱子里面既死又活的猫一样荒唐。

但是,后来又有一个物理学家尤金·维格纳在“薛定谔的猫”的基础上又做了一个思想实验,这次他不单单是为了嘲讽哥本哈根不解释了,而是借由思想实验来正面解释叠加态的坍缩了。这个思想实验就是“维格纳的朋友”(Wigner’s Friend)。刚刚我们说了,箱子里的猫处于一种既死又活的叠加态,维格纳设想的场景是,把放了毒药的箱子里,再加入一个维格纳的物理学同行朋友,当然不是像那只猫那样同行会被毒死,而是魏格纳的同行朋友戴着一个防毒面具在箱子里面观察这只猫,那观察会造成什么效果?

我们之前说了,在双缝实验中,在实验人员没有观测之前,粒子处于既左又右的叠加态,而一旦实验人员用仪器观测了,粒子就顿时坍缩成要么左要么右的确定态了。问题就在于,为什么人的观测会让一个处于叠加态的粒子坍缩成确定态?人的观测在量子力学里面起到什么作用?

让我们回到箱子里面的朋友,他由于在箱子里面能观测到猫的生死状况,所以观测就会使得猫从既死又活坍缩成确定的要么死要么活,当然,到底坍缩成死还是活是随机的。此时,我们再设想,在箱子之外站着维格纳本人,由于维格纳观测不了箱子里面的状况,哪怕他箱子里面的朋友已经观测到猫坍缩成要么是死要么是活的确定状态,但箱子外面的维格纳并不知道他朋友观测出了什么结果,对于维格纳而言,这只猫连同箱子内的朋友一起都处于一种量子叠加态。

现在我们来设想这样一种情况,箱子内的朋友观测到,猫随机坍缩成死的了,但是,箱子外面的维格纳没有观测到,因而完全存在一种可能——维格纳打开箱子,观测箱子内部以后,发现这只猫坍缩成了活的,因为整个箱子对维格纳而言都处在量子叠加态,它坍缩成什么样,完全是随机的,它完全有可能是猫坍缩成了活的。所以,思想实验就造成了一个悖论,而解决悖论的钥匙是,对于同一个物理事件,朋友观测到的结果和维格纳观测到的结果完全可以是不同的。

这个思想实验在哲学上进一步揭示了,并不存在所谓的“客观现实”,不同的人对于同一个物理现象,完全可以观测出不一样的结果。别以为这仅仅是思想实验,后世的物理学家通过实验证实了维格纳的这一思想,客观现实并不存在,观察的结果取决于观察者的主观视角。波函数的坍缩很可能是一个主观的东西。

维格纳的这一思想让我们知道,量子力学的机制中有一些“主观”的东西在里面,之前说了,由于人的观测,叠加态的波函数会随机坍缩成一种确定态,而为什么人的观测会让波函数坍缩?很可能就是因为人的意识。其实,不单单是维格纳认为量子力学里面有人的意识参与其中,多学科的大佬冯·诺依曼也认为是人的意识让波函数坍缩了。物质决定意识,物质可以改变我们的意识,但同时我们的意识也可以反过来改变物质。箱子里的猫是死是活是由我们观测者主观的意识决定的。

量子力学的波函数坍缩具有主观性,那么,世界上还有什么东西也是主观的?那就是人的意识了。我们之前说了,人的意识的重要的一个层面就是现象意识,就是意识给我们带来的一种无法用第三人称的语言或者科学描述说得清楚的主观感受,这种主观感受怎么解释?刚刚说了半天量子力学也具有这种主观性,那么会不会人意识产生的机制,就是一种量子力学机制?

我们现在说回彭罗斯了,彭罗斯就认为我们的脑神经细胞的细胞质里面就有这么一种特别微小的结构,彭罗斯把它叫做“微管”,微观由于足够小,它里面就允许存在微观世界里面的量子叠加态。这也就是说,我们大脑里面的神经信号的传递过程是基于一种更为底层的量子过程,所以我们大脑里面的一些想法的变化就是由于微观的叠加态坍缩了,随机坍缩成了一种确定的状态,从而进一步造成了脑神经信号的传递。这就是意识产生的底层机制。

要知道,如果我们的意识的产生机制是基于量子力学的波函数坍缩机制的话,这不仅仅解释了意识的难题,这也解释了自由意志哲学大问题,如果量子意识理论是对的话,那么人就是有自由意志的,人的想法、意愿、选择就不是被经典力学里的机械决定论所决定的,而是真随机的,我既可以向左,也可以向右,既可以点肯德基,又可以点麦当劳,在微管里面的波函数坍缩之前,我的选择就是不确定的,这就为人的自由意志保留了空间。

我们怎么把量子意识理论应用到机器意识的工程学上面?答案是量子计算机。彭罗斯就认为,人脑并不是一台传统架构的计算机,因为波函数坍缩是真随机,这玩意是传统计算机算不出来的。但是,现在有量子计算机,传统计算机实现不了的波函数坍缩的真随机性,量子计算机就能实现。所以,如果要模拟人脑的意识就得用量子计算机。量子计算机的原理就是利用量子力学的波函数坍缩的真随机性,来取代传统计算机的要么是0要么是1的这种确定性计算。总之,量子意识理论告诉我们,人的意识的产生机制是一种量子力学机制,人的现象意识的主观性是怎么来的?就是量子力学带来的,因为量子力学的波函数坍缩,在维格纳和冯·诺依曼等人看来,也是具有主观性的。

当然,量子意识理论的缺点,就是我们这一小节一开始说的,就是有点玄,量子力学玄学加上意识问题玄学,玄而又玄。话说回来,比起之前几个意识理论,之前的理论都是在宏观层面搭建模型来解释意识,而量子意识理论就企图从最硬核、最底层的方面,试图一举攻克意识难关,虽然理论有很多地方还说不清楚。

会议总结

本次AI取代人类工作研讨会摘要如下:

高阶表征理论:

意识产生于对一阶表征的高阶再表征。

全局工作空间:

意识产生于局域性的认知模块被全局广播。

信息整合理论:

意识产生于整体系统对大量信息的整合。

预测加工理论:

意识产生于预测模型对外部信息的主观建构。

量子意识理论:

意识产生于脑中微小结构的波函数坍缩效应。

对上述言论,如果想要进一步了解详情的话,可以参考:

◆大卫·J·查尔莫斯 著,《有意识的心灵》,朱建平译,中国人民大学出版社,2013年。

◆秦瑞琳、周昌乐、晁飞 著,《机器意识研究综述》,载于《自动化学报》,2021年。

◆Rosenthal.D. ‘Thinking that one thinks,’ in Davies and Humphreys (eds) 1993.

◆伯纳德·巴尔斯 著,《意识的认知理论》,安晖译,科学出版社,2014年。

◆Tononi, Giulio; Boly, Melanie; Massimini, Marcello & Koch, Christof (2016). Integrated Information Theory: From Consciousness to Its Physical Substrate. Nature Reviews Neuroscience 17 (7):450–461.

◆阿尼尔·赛斯 著,《意识机器》,桥蒂拉译,中译出版社,2023年。

◆罗杰·彭罗斯 著,《皇帝新脑》,许明贤/吴忠超译,湖南科学技术出版社,2018年。

欢迎你也同哲学家们一起参与到对这个大问题的讨论之中,他们的看法发表完了,现在,轮到你来发言了,请投出你的一票,并在留言区发表你的看法!

投票

注:投票敬请前往 大问题Dialectic 公众号 原文下进行。

转载请注明:好奇网 » 大问题:如何让AI具有意识?