01

当AGI成为一种必然的宿命

机器大军正在向我们逼近,或者说,我们被告知如此。不是今天,但也为期不远,快到我们似乎必须在它们的包围到来之前,重新组织整个人类文明。在董事会的会议室、大学的讲坛、议会的听证会,以及那些令人窒息的科技报道中,超级智能的幽灵正愈发频繁地在我们的话语体系中盘桓。

它通常的描述是“通用人工智能(AGI)”,有时则会被描绘得更加广泛,但始终被视作一种在所有领域都超越人类认知的人造心智,能够实现递归的自我改进,甚至可能对人类生存构成威胁。但无论叫什么名字,这种即将到来的超级智能,已经占据彻底殖民了我们的集体想象。

这个场景呼应了科幻小说的推测性的谱系,从阿西莫夫的“机器人三定律”(一种试图限制机器自主权的文学尝试),到后来的斯坦利·库布里克和阿瑟·C·克拉克的HAL 9000,或是威廉·吉布森笔下的失控网络。这些曾经属于描述性思维实验的领域,如今却成为一种准政治的预言(Quasi-political Forecast)。

02

超级智能的叙事:一种权力的装置

这个叙述与任何科学共识都关系不大,它实际上是从特定的权力回廊中滋生出来的。那些最高调的超级智能预言家,恰恰是那些正在构建他们所警告之系统的始作俑者。当山姆·奥特曼一边高谈阔论AGI对人类的生存威胁,一边争分夺秒地推动其开发,或者当埃隆·马斯克一边警告AI末日,一边创办公司加速其发展时,我们看到的是一种以预测为名的政治伪装。

超级智能的话语体系作为一个精密的权力装置在运作,它将关于企业责任、工人失业、算法偏见和民主治理等现实问题,转化为关于意识和控制的抽象哲学谜题。这种障眼法并非偶然,也并非无害。通过将假设性的灾难置于公众讨论的中心,AI系统的架构师们把自己定位为不被人类接受的守护者,背负着可怕的真相和巨大的责任。他们摇身一变,成为文明与其潜在毁灭者之间不可或缺的中介,而巧合的是,这一角色恰恰需要巨额资本投入、最少的监管和高度集中的决策权。

试想这种框架是如何运作的?当我们讨论未来的AGI是否可能消灭人类时,我们并不是在谈论被算法监控所支配的亚马逊仓库工人,也不是在谈论那个社区被自动武器系统锁定的巴勒斯坦人。在存在主义风险的宏大修辞面前,这些当下的现实逐渐被淡化为背景噪音。这些痛苦是真实的,而超级智能仍然是理论上的;但我们的注意力和资源——甚至我们的监管框架——却越来越多地转向后者,各国政府正在组建前沿人工智能工作坊,并为尚属假设的未来系统性风险起草预案。与此同时针对当前的劳动保护和算法监控的限制,却依然被束缚在日益捉襟见肘的立法之中。

在美国,关于“对人工智能安全、可靠和可信地开发与使用”的第14110号行政命令,虽然提及了民权、竞争、劳动和歧视等问题,但其最有力的问责义务却指向了大型、高能力的基础模型以及未来计算量超过一定阈值的系统,要求企业向联邦政府分享技术信息,并证明其模型符合特定的安全限制。英国则走得更远,成立了前沿人工智能工作坊——现已并入人工智能安全研究所,其职责聚焦于极端的、假设性的风险。欧盟人工智能法案(AI Act),没有试图规范当前AI带来的危害,却仍然专门设有一节讨论未来某个未知时间点可能出现的系统性风险和基础模型风险。在这些司法实践中,政治能量都聚集在未来的、推测性的系统之上。

超级人工智能的叙事,正在非常有意识地推进一项政治议程,即将注意力从当前的控制体系转移到遥远的灾难上,把讨论焦点从现实的力量转移到想象的未来。关于机器封神的预言重塑了权威的获取方式,以及由谁的利益来掌舵 AI治理;同时压制了那些在算法下受苦者的呼声,放大了那些希望人类灭绝的声音,使这些声音主导了讨论。这种伪装成中立未来主义的论调,实则是对当下政治经济的一种干预。擦亮双眼,超级智能的预言更多不是关于机器的警告,而是在为权力服务,而这种策略,必须被识破。这一叙事的力量,正源自其历史。

03

在理性主义的祭坛前膜拜

超级智能作为主导AI叙事,在ChatGPT之前就已出现,可以追溯到20世纪50年代冷战战略与计算理论之间奇特的结合。作为智库的兰德公司(RAND Corporation),其核战略家们曾模拟人类文明的毁灭,为将智能视为与文化与政治绝缘的纯粹计算这一概念提供了思想温床。

早期的AI先驱继承了这一框架,当艾伦·图灵提出他著名的测试时,他有意回避了意识或经验的问题,转而关注可观察的行为——如果一台机器仅通过文字就能让人类对话者相信它具有人性,那么它就值得被称为智能。这种行为主义的简化之后被证明是关键性的,因为它将思维视为可量化的操作,从而将智能重新定义为可以被衡量、排序,最终被机器超越的东西。

据数学家乌拉姆(Stanislaw Ulam)回忆,早在1958年,计算机科学家冯诺依曼便谈及一种技术奇点,即加速的进步终将使机器能够改进自身设计,迅速将自身提升到具有超越人类的能力。这一概念在20世纪60年代由数学家欧文·古德(Irving John Good)进一步完善,奠定了超级智能讨论的基本框架:递归式的自我进化、指数级的增长,以及人类所需要发明的最后造物。当然,这些只是数学上的推演而非实证观察,但此类推测与思想实验被如此频繁地复述,以至于它们获得了预言般的重量,使其所描绘的想象未来显得不证自明。

20世纪80年代和90年代,这些思想从计算机科学系的象牙塔,迁徙到了一种独特的亚文化圈层,一群围绕着计算机科学家尤德科夫斯基(Eliezer Yudkowsky)及其奇点研究所(后更名为机器智能研究所)的理性主义者和未来主义者。这个群体构建了一个关于超级智能的理论框架,即效用函数,一个旨在指导人工智能决策的形式化目标系统。

在回形针思想实验中,他们设计了一个高度先进的人工智能,它的唯一目标是尽可能多地制造回形针。这个微不足道的目标促使机器消耗所有资源。该思想实验突出了工具性收敛的可能,即几乎任何目标都会促使人工智能寻求权力和资源。这个思想实验还提出了正交性论题(Orthogonality Thesis),该定理认为智能与道德价值是独立的。他们为一个并不存在的实体创造了一套学术化的哲学体系,包括对不同类型的人工智能失控情景给出了细致分类,以及对可能的未来智能间非因果(acausal)权衡,给出了详尽论述。

这些思想家的共同点在于他们对某种推理风格的坚定承诺。他们的实践或许可以被称为极端理性主义,即相信纯粹的逻辑,在脱离经验约束或社会背景后,仍能够揭示关于技术和社会的根本真理。这种方法优先考虑思想实验而非数据,重视巧妙的悖论而非日常观察,其结果是一套读起来如同中世纪神学,精妙而复杂,但却完全脱离了人工智能系统实际发展的论述。诚然,我们应当承认,这种脱节并不意味着他们的努力毫无价值,相反,通过将抽象推理推向极限,他们澄清了关于控制、伦理和长期风险的问题,这些问题后来为更加务实的AI 政策和安全讨论提供了基础。

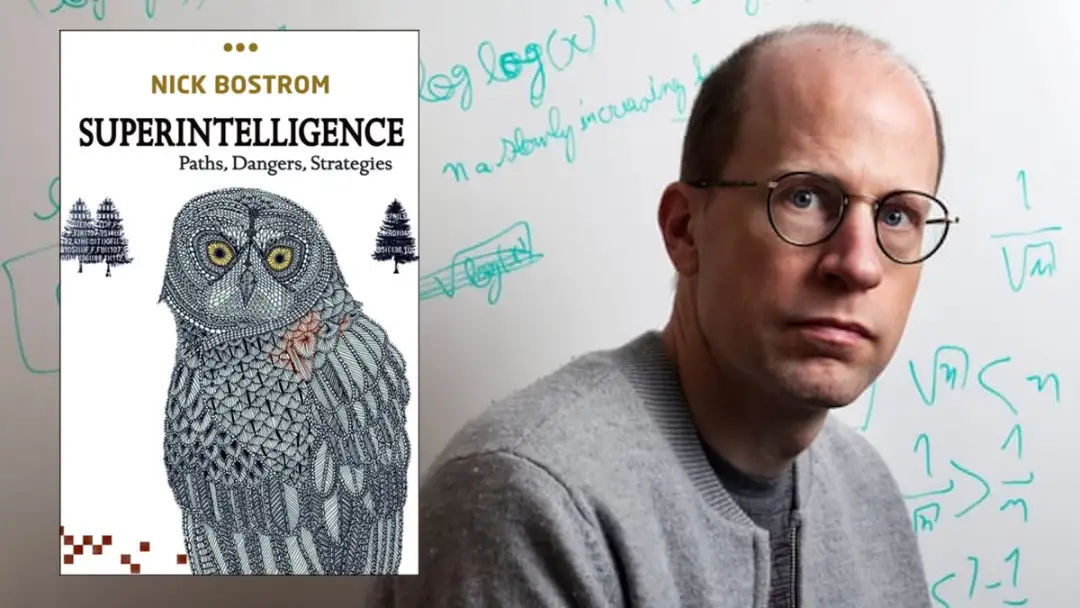

这一传统在当代体现最显著的表述,出现在波斯特洛姆(Nick Bostrom)2014年的著作《超级智能》中,该书将边缘化的互联网哲学转变为主流讨论。作为前牛津大学哲学教授,波斯特洛姆赋予了此前只存在于科幻小说和以晦涩标题命名的博客中的情景以学术上的严肃性。尽管他的书中没有包含任何实证的AI研究,也几乎没有涉及实际出现的机器学习,但它却成为硅谷的必读书目,常被科技亿万富翁引用。

马斯克曾推特表示:“波斯特洛姆的《超级智能》值得阅读。我们需要对AI格外谨慎。它可能比核武器更具危险性。”马斯克提醒人们保持谨慎是正确的,这从他自己的人工智能公司向孟菲斯的Boxtown(一个以黑人为主的工人阶级社区)排放1200至2000吨氮氧化物及甲醛等有害空气污染物的行为中,便可得到佐证。

这篇评论并非试图贬低波斯特洛姆的成就,他的功绩在于将关于AI的那些蔓延且往往语无伦次的恐惧,梳理成了一个严谨的框架。但他的书有时读起来像是一项自然历史研究项目,他像分类学家一样,将通往超级智能的不同路径、各种“失败模式”(即系统可能出错或毁灭我们的方式),以及“控制问题”的解决方案(即保持AI对齐的方案)分门别类。这种分类学的方法,甚至让最狂野的臆测也披上了科学的外衣。通过将超级智能视为系统性研究的对象而非科幻设定的前提,波斯特洛姆成功地将存在性风险洗白进了体面的话语体系之中。

04

有效利他主义:

理性的计算与被遮蔽的痛苦

有效利他主义(effective altruism)运动为这些理念提供了社会基础设施。其核心原则是通过理性计算,以最大化长期收益。在这一世界观中,超级智能的风险被严丝合缝地嵌入其中,因为如果未来的人与现在的人一样重要,而一次小概率的全球性灾难所造成的危害超过了持续的伤害,那么防止人工智能末日就成为首要任务。按照这种逻辑,假设中出现在未来的生命,其优先级会超越当下人们所经历的痛苦。

这并非仅仅是书斋里的抽象辩论,因为认同有效利他主义的慈善家们将大量资金投入了人工智能安全研究,而资金决定了研究人员关注的方向。与有效利他主义理念一致的组织已在大学和政策领域建立,发布报告为政府提供关于人工智能的思考建议。英国的前沿人工智能特别工作坊(Frontier AI Taskforce)包括了与有效利他主义运动有明确关联的成员,评论人士认为这些联系有助于将有效利他主义认定的优先事项加入到政府有关人工智能风险的政策中。

有效利他主义鼓励其支持者进入公共机构和主要实验室,从而形成一条将这些优先事项带入决策核心的人才管道。前美国政府机构“情报高级研究计划局”(Intelligence Advanced Research Projects Activity)主任Jason Matheny曾描述过,有效利他主义者可以通过“在政府职位中摘取低垂的果实”来施加影响。超级智能的讨论之所以传播,不是因为专家普遍认为这是我们最紧迫的问题,而是因为一场资源充足的运动为其提供了资金和接触权力的渠道。

这并不是要否认与有效利他主义理念或与Bostrom所阐述的超级智能这一概念进行交流所带来的价值。问题在于,一旦这些理念进入政治和商业领域,它们是何其容易被曲解。理清这段超级智能的思想谱系很是重要,因为它揭示了超级智能讨论作为一种文化产物的特性,这些理念已经超越了理论,进入了制度领域,获得了资金和倡导者。而它的出现根植于那些推崇理性主义而非经验主义、将个人天才置于集体判断之上、并优先考虑技术决定论而非社会背景的制度中。

05

末日企业家真正在乎的

是利润而非人类的安全

超级智能从一种边缘的互联网哲学蜕变为董事会的顶级战略,无疑是21世纪最成功的意识形态战役之一。那些此前只盯着季度财报和用户增长曲线的科技高管,突然开始像神秘主义者一般,高谈阔论人类的宇宙宿命。这种转变重塑了人工智能发展的政治经济格局。

OpenAI,这家成立于2015年、旨在确保人工智能造福全人类的非营利组织,正是这一转型的缩影。OpenAI已演变为一种奇特的嵌合体,它是一个由非营利董事会控制的“利润上限”公司,估值高达5000亿美元,却在争分夺秒地构建那个它自己警告可能会毁灭我们的AGI。这种结构因其复杂性而显得繁复,但在超级智能的逻辑中却完全合情合理。如果AGI既是终极的应许之地,又是存在的终极威胁,那么构建它的组织就必须是矛盾的统一体,既商业又利他,既激进又审慎,既胸怀天下又讳莫如深。

OpenAI的首席执行官奥特曼已将勉为其难的先知(Reluctant Prophet)这一修辞姿态修炼得炉火纯青。在国会听证、博客文章和采访中,他一方面警告人工智能的潜在危险,另一方面又坚持推进技术发展的必要性。他今年早些时候在自己的博客上写道:“我们的使命是确保AGI能够造福全人类。”他的论点中有一种强烈的紧迫感,认为我们必须在其他人之前完成AGI的构建,因为唯有我们才拥有足够的责任感去驾驭它。奥特曼似乎有意将OpenAI定位为人类的代表,背负着创造类神智能的可怕重担,只为将其关进笼子里。

尽管如此,OpenAI也在追求利润。而这一切真正围绕的,就是利润。超级智能的叙事带来了巨大的财务影响,为尚未展现出持续自给自足能力的公司赋予天文数字的估值。毕竟,如果你正在打造人类的最后发明,传统的商业指标或许便不再适用。这种末世论框架解释了为何微软会向OpenAI投资130亿美元,为何风投机构热衷于投资致力于AGI的初创公司,以及为何市场会将像ChatGPT这样的大语言模型视为全知的先驱者。

由前OpenAI高管创立的Anthropic,将自己定位为“安全导向”的替代方案,承诺打造“有用、诚实且无害”的AI系统,从而筹集了数十亿美元资金。但这一切不过是一场精心编排的安全表演,因为AI带来的危害在OpenAI、Anthropic、Google DeepMind等公司之间的竞争中,并没有真实的立足之地,真正的较量在于谁能够构建出最佳、最盈利的模型,以及谁能更好地用谨慎的语言包装这场野心勃勃的追逐。

06

超级智能的自我实现预言排除民主讨论

这种动态引发了一场底线竞赛,每家公司都以竞争对手可能不够谨慎为由,为自己的加速辩护:中国人来了,如果我们放慢速度,他们就会率先构建对齐不当的AGI。Meta在没有适当保障的情况下发布了开源模型。如果某个无名之辈率先突破了怎么办?这种偏执的逻辑封死了任何真正的暂停或民主商议的可能。于是,速度即安全,审慎即鲁莽。

超级智能的讨论也重塑了企业内部的政治格局,AI安全团队通常由相信存在性风险的成员组成,他们为激进的开发提供道德掩护,通过强化“我们在拯救世界”的信念,消解了针对商业行为的批评。如果你的安全团队正在发表关于防止人类灭绝的论文,那么常规的商业监管看起来便显得微不足道了。

2023年11月OpenAI那场广为人知的宫斗大戏,将这些动态暴露无遗。当董事会因质疑奥特曼的坦诚而试图解雇他时,由此引发的混乱暴露了公司内部潜在的权力关系。那些被“拯救人类”的愿景招募进来的员工,他们威胁如果他们的CEO不被重新任命,就要集体辞职。他们对奥特曼的忠诚,竟压倒了拯救人类的使命?尽管微软并未正式掌控OpenAI董事会,但作为公司的主要资助者和云服务提供商,它在关键时刻发挥了决定性影响,提出雇佣Altman及其追随者。最终,那些认为“诚实是CEO重要品质”的董事会成员黯然离场,奥特曼凯旋归来。

超级智能的宣传服务于权力,当它与资本和控制所带来利益发生冲突时,就会被搁置一旁。这从来不是关于拯救人类,而是关于利润。

宣扬人工智能末日的创业者们发现了一个完美的公式。通过警告存在性风险,他们将自己定位为不可或缺的角色;通过竞相构建AGI,他们为无限制地使用资源提供了正当理由;通过声称拥有独特责任,他们转移了民主监督的关注点。未来成了当下资本积累的人质,而我们却被告知要对这些负责任的看守者心怀感激。

超级智能的讨论积极地塑造着未来。通过不断重复,推测性场景获得了宿命般的力量。这一过程制造了必然性,揭示了权力如何通过预言发挥作用。

试看那个断言:AGI将在5到20年内出现。在许多信源中,这一预测出人意料地保持稳定。但自20世纪中叶以来,研究人员和未来学家就反复承诺“在几十年内”会出现人类水平的人工智能,但这一时间线却不断后移。这种移动的时间窗口具有特定的功能:它足够近,可以为立即的大规模投资提供正当理由,又足够远,可以推迟必要的问责。它创造了一个时间框架,在此框架下,无论民主讨论的情况是怎么样,某些行动都会变得不可避免。

这种必然发生的叙事渗透到硅谷对人工智能的讨论中。高管们宣称,AGI的到来是不可避免的,无论我们是否喜欢,仿佛技术发展是一种自然力量,而非人类的选择。这种将进步自然化的说法,掩盖了那些使某些未来比其他未来更有可能发生的具体决策、投资和基础设施。当科技领袖说我们无法阻止进步时,他们真正想表达的是,你们无法阻止我们。

媒体的推波助澜在这一过程中起着至关重要的作用,因为大语言模型的每一次小幅改进都会被描绘成通向AGI的一步。ChatGPT能写诗,显然意识即将来临。Claude能解决编程问题,奇点已经临近。这类说法往往源自构建这些系统的企业本身,营造出一种趋势,这种趋势逐渐成为自我实现的预言。投资者因此投资,因为AGI似乎触手可及;研究人员加入公司,因为未来正在那里被构建;政府推迟监管,因为他们不想拖累本国的领头羊。

AGI必然发生这一叙事模式也通过语言选择加以构建。注意“AGI”如何迅速取代“人工智能”在公共讨论中的地位,仿佛通用智能是自然演化的必然结果,而非一个具体且存在争议的概念。“超级智能”——或者这个概念最终采用的任何其他术语似乎自然而然地成为这架阶梯上的下一步。请注意,“对齐”,即确保人工智能系统做人类想要的事情是如何成为AI安全领域核心问题的,它假设了超人智能的存在,并将它带来的挑战视为技术问题而非政治问题。

再考虑“算力”这一原本指代计算资源的词,是如何在当下成为一种像石油或谷物一样,可以被囤积和控制的可量化的资源。这种语义转变很重要,因为语言塑造可能性。当我们接受AGI是不可避免的,我们就不再追问是否应该去建造它,而在这种喧嚣中,我们却忽略了我们不经意间已经默认了由一小群技术专家来决定我们的未来。

当我们同时将算力视为一种战略资源时,我们进一步将权力集中于那些掌控数据中心的人手中,而这些人,正如奥特曼被罢免事件所展示的那样,这又将更多的权力赋予这一小撮人。

本应抵制这种逻辑的学术机构,已被征召进这场必然性的制造中。渴望产业资金和相关性的大学,纷纷设立AI安全中心和存在性风险项目。这些机构表面上独立,却最终强化了产业叙事,它们撰写关于AGI时间线和对齐策略的论文,为科幻小说赋予学术权威。年轻的研究人员看到资金和声望集中在超级智能问题上,便将职业方向转向超级智能相关议题,而非当下人工智能的危害。

国际竞争进一步强化了超级人工智能必然出现的叙事。美国和中国之间的“人工智能军备竞赛”被描述为存在主义层面的较量:谁率先构建出AGI,谁就将获得永久的地缘政治主导权。这种新冷战的修辞方式排除了合作、监管或克制的可能性,让冲向危险技术的竞赛看起来像是爱国主义,而非鲁莽举动。国家安全再次成为压制民主讨论的王牌。

这一预言通过资源集中实现了自我应验——随着资源不断流向AGI研究,其他AI研究方式逐渐被边缘化。原本可能从事可解释AI或用于研究AI向善的科研人员,转而加入专注于增加大语言模型规模的实验室。未来变得狭窄,并非由于预言本身准确,而是因为预言号令了资源的分配。

从财务角度来看,这是一种“正面我赢,反面你输”的安排:如果承诺的突破得以实现,私营公司及其投资者将获得全部收益;但如果进展停滞或未能达到预期,耗能巨大的数据中心和重新调整的产业政策所产生的沉没成本,则由公共资产负债表买单。整个宏观经济正被绑定在一个超级人工智能必然出现,这一我们尚未完全理解其基本物理规律的故事上。

我们必须认识到这一过程是政治性的,而非技术性的。超级智能必然发生的叙事,是通过对特定的资金、注意力和合法性进行选择而制造出来的,不同的选择将导致不同的未来。根本性的问题不在于超级智能是否会到来,而在于谁从让我们相信它会必然到来中获益。

▷Wenyi Geng

▷Wenyi Geng

07

超级智能叙事之外被遗弃的现在

当我们沉迷于假设的机器神明之时,现实中的AI系统正在以深刻且常常有害的方式重塑人类生活。关于超级智能的讨论不仅转移了人们对这些直接影响的注意力;甚至可以说,它为这些影响提供了合法性。毕竟,如果我们正在竞相奔向AGI以拯救人类,那么过程中的些许附带损害又算得了什么?

以劳动为例,这一人类创造与再生产世界的根本活动。AI系统已经通过算法管理控制了数百万工人的日与夜。在亚马逊仓库中,工人的行动由手持设备决定,这些设备计算最优路径,监控休息时间,并自动解雇那些跟不上节奏的工人。虽然关于自动化的文化讨论常常强调它在取代人类劳动这一点上的威胁,但对许多人来说,残酷的现实是自动化已经让许多工人已成为算法的附属品,执行机器尚无法完成的任务,同时被计算系统衡量和监控。

弗雷德里克·泰勒是19世纪的美国机械工程师,也是《科学管理原理》的作者,他因通过严格控制劳动来实现最大效率而闻名。如今,我们所处的是一种以技术为中介的泰勒主义,工作被分解为微小的、经过优化的动作,每一个动作都被监控和计时,唯一的区别在于,管理的鞭子从秒表变成了代码。泰勒的逻辑已经被以远超他本人想象的方式实践和应用。但当我们讨论人工智能与工作时,话题总会瞬间跳跃到“AGI是否会消灭所有工作”,仿佛当下那些被算法驱使的工人的苦难,仅仅是通往废弃途中的一个中转站。

内容审核产业是这个“被遗弃的现在”的缩影。数以十万计的工人,主要来自全球南方国家,每天查看人类所制造的最恶劣内容——包括儿童虐待和性暴力,以训练人工智能系统识别和过滤此类材料。这些拿着硅谷同行零头薪水的工人,承受着有据可查的心理创伤。他们是“人工智能安全”的幕后劳动大军,在保护用户免受伤害的同时,自身却遍体鳞伤。然而,他们的痛苦很少出现在人工智能伦理的讨论中,因为那里的讨论总是围绕着如何防止超级智能在未来可能带来的假设性危害。

监控代表了另一个被未来主义猜想所掩盖的现实。人工智能系统能对人类行为以前所未有地精确度进行追踪。人脸识别技术可以识别抗议者和异见人士。预测性警务算法将执法资源引导至与种族人口统计数据神秘相关的一些“高风险”社区。边境控制机构利用人工智能通过语音分析和微表情来评估寻求庇护者的可信度。社会信用系统则通过分析个人的数字足迹,用算法对公民的可信度进行评分。

这些并非是想象中的技术;它们已经是实际部署的系统,它们不需要通用人工智能,只需要大规模的模式匹配。但在超级智能的话语体系中,监控被处理为一种未来的风险(万一AGI监控所有人呢?)而非当前的现实。这种时间错位有利于当权者,因为讨论假设性的全景监狱,比拆除现有的监控系统更容易。

算法偏见已渗透到关键的社会基础设施中,通过赋予人类偏见以数学权威,放大并合理化了现有的不平等。人工智能行业的回应是技术官僚式的:我们需要更好的数据集、更多样化的团队和算法审核,这是用技术手段解决政治问题。与此同时,这些公司正争先恐后地构建AGI,却大规模部署带有偏见的系统,将当前的伤害视为通向超越之路上的可接受代价。暴力是真实的,但解决方案却始终被无限期地推迟。

而在这一切之下,随着我们持续训练大语言模型,环境破坏正加速进行。大语言模型的训练消耗了海量能源。当被质问这种生态代价时,人工智能公司便抛出假设性的红利:例如AGI将解决气候变化或优化能源系统。他们用未来为现在开脱,仿佛这些投机性的收益应该超过当前实际发生的损害。这种时间上的把戏,以拯救世界之名行毁灭世界之实,如果不是后果是如此惨烈,倒也像是一出喜剧。

正如它侵蚀环境一样,人工智能也在侵蚀民主。推荐算法早已通过制造过滤气泡和放大极端主义重塑了政治话语,但最近,生成式人工智能则向信息空间中倾泻了海量的内容,使得人们难以区分真相与虚假信息。公共领域是民主生活的基础,它依赖于人们有共享足够的信息以便进行公共讨论。

当人工智能系统将公民细分到越来越狭窄的信息流时,这个共享空间就崩塌了。我们不再争论相同的事实,因为我们不再身处同一个世界。然而,我们关于治理的讨论却聚焦于“如何防止AGI在未来摧毁民主”,而非解决“当前的 AI系统如何正在瓦解民主”。我们争论人工智能对齐问题,却忽视了在关键问题上,在人类之间需开展的对齐,例如人工智能系统是否应该服务于民主价值,而不是企业利润。设想中的超级智能专制掩盖了现实中的监控资本主义专制。

随着人类适应算法做出的判断,人工智能对心理健康造成的影响逐渐累积。为最大化参与度而优化的社交媒体算法,推流着引发焦虑、抑郁和饮食障碍的内容。年轻人将算法定义的指标,例如点赞、分享和观看次数内化为衡量自我价值的标准。通过人工智能系统对社会生活的量化,产生了新的异化和痛苦形式,但这些即时的心理危害与人们想象中的存在性风险相比微不足道,而后者却获得了远多于预防假设的超级智能灾难所应投入的关注和资源。

这些当前的危害都可以通过集体行动来应对。我们可以规范算法管理,支持内容审核员,限制监控,审查偏见,控制能源使用,保护民主并优先考虑心理健康。这些并非需要超级智能才能解决的技术难题,而是需要民主介入的、老派的政治挑战。然而,超级智能的讨论却让这些平凡的干预措施显得几乎过时。当工作本身可能很快就会消失,为什么我们还要重新组织工作场所?当AGI可能已经能监控我们的思想,我们为什么还要对监控加以监管?当超级智能可能完全超越人类的偏见,我们为什么还要处理当下的偏见?

这个被遗弃的当下,充满了可以通过人类选择而非机器超越来缓解的痛苦,而我们每花一分钟讨论尚未存在的AGI对齐问题,就等于少花一分钟去应对此刻正伤害着数百万人的算法暴行。未来导向的超级人工智能叙事不仅仅是干扰,而是一种遗弃,是一种故意的背过身去,逃避当下的责任,以此换取臆想中的赦免。

08

人工智能时代的替代想象

超级智能叙事的主导地位掩盖了一个事实:AI 的道路不止一条。存在着许多基于当下社会需求、而非膜拜假设中机器神明的替代路径。这些替代方案表明,你不必非得加入那场通往超级智能的亡命赛跑,也不必彻底背弃技术。此时此刻,我们完全可以以不同的方式构建和治理自动化。

全球各地,社区已经开始尝试不同的数据组织和自动化方式。例如,原生数据主权运动(Indigenous Data Sovereignty)已经发展出治理框架、数据平台和研究协议,将数据视为一种需要集体同意的公有资源。加拿大首个信息治理中心(First Nations Information Governance Centre)和新西兰的Te Mana Raraunga等组织坚持认为,数据项目(包括那些涉及AI的项目)必须对其关系、历史和义务负责,而不仅仅是对优化指标和规模扩张负责。他们的项目提供了自动系统的设计实例,这些系统旨在尊重文化价值并加强地方自主性,这与有效利他主义的冲动形成镜像,不会为了假设的未来人群而抽象地脱离具体地点。

工人也在尝试不同的安排,工会和劳工组织正在就算法管理协商条款,争取对工作场所系统的审计权,并开始建立由工人控制的数据信托,以管理他们的信息如何被使用。这些举措源于实际生活经验,而非哲学推测,它们来自那些每天都在算法监控之下生活的人们,他们决心重新设计管理他们生存的系统。而当科技高管因对AGI的推测而受到赞誉时,那些分析已有系统的人们却容易被轻易地视为卢德主义者。

类似的实验也出现在以女性主义和残障为中心的技术项目中,这些项目围绕关怀、可及性和认知多样性构建工具;还出现在全球南方的倡议中,这些倡议使用适度、由本地社区管理的AI系统,在资源有限的情况下支持医疗、农业或教育。不关注增长的技术专家正在设计低功耗、社区托管的模型和数据中心,旨在嵌入生态极限之中,而非试图凌驾其上。这些案例表明,批判与行动主义完全可以转化为具体的基础设施和制度安排,证明了AI的组织方式不必默认那个“为了少数科技兄弟眼中的大善而牺牲所有人”的超级智能范式。

这些多样化的想象——原生数据治理、工人主导的数据信托以及为全球南方设计的AI项目,其共同点在于对“智能”本身的另一种理解。他们并不将智能视为一种抽象的、脱离身体的、能够优化所有领域的能力,而是将其视为一种与特定情境紧密关联的、具有关系性和具身性的能力。他们关注的是真实存在的社区及其现实需求,而非假设的人类面对假设的机器。正因如此,它们与在超级智能的宏大叙事相对比时显得谦逊,毕竟,存在性风险让所有其他担忧都显得微不足道。你几乎能听到那些反驳:当工作本身都快消失了,谈论工人权利有何意义?当AGI被设想为能够按需解决气候变化问题时,为何还要考虑环境限制?

这些替代方案也揭示了超级智能叙事中的民主缺失。将人工智能同时包装为普通人无法理解的神秘技术问题,以及不可置疑的社会进步引擎,使得权力得以在系统拥有者和构建者手中高度集中。一旦算法参与到沟通、就业、福利、执法和公共讨论,它们就成为政治机构。这种权力结构是封建式的,一小撮企业精英凭借“特殊知识”和“末日紧迫感”垄断决策权,而公民和纳税人则被告知他们无法理解这些技术复杂性,且任何减速都是在全球竞赛中的不负责任。其结果是习得性无助,一种认为技术未来无法通过民主方式塑造,只能被托付给那些“远见卓识”的工程师的宿命感。

一种民主的方法会颠倒这种逻辑,认识到关于监控、工作自动化、公共服务,甚至对超级智能的追求等问题,并不是工程难题,而是价值选择。公民不需要理解反向传播算法,就可以讨论预测性警务是否应该存在,正如他们不需要理解热力学,就可以辩论交通政策。民主,要求我们要有权塑造集体生活的条件,其中必然包括人工智能的架构。

这可以有多种形式。工人可以参与关于算法管理的决策。社区可以根据自身优先事项管理本地数据。关键的计算资源可以由公共或合作方式拥有,而不是集中在少数公司手中。市民大会可以被赋予实际的决策权,决定一个城市是否推进有争议的AI应用,例如人脸识别和预测性警务。开发者可以在预防性框架下被要求在部署前证明其安全性。国际协议可以对AI研究中最危险的领域设定限制。所有这些都不是在讨论AGI或其他可以想象的超级智能是否会或不会出现;它只关乎一个认知:技术权力的分配是一种政治选择,而非不可避免的宿命。

超级智能的叙事通过将集中权力描绘为悲剧性的必然,削弱了这些民主实践的可能性。如果人类灭绝近在咫尺,公众商议便成了我们负担不起的奢侈品。如果AGI是不可避免的,那么治理权就必须让渡给那些正在竞相构建它的群体。这种叙事制造紧迫感,以合理化对民主的侵蚀。于是,最初关于假设性机器的故事,最终却演变为关于现实政治权力丧失的故事。归根结底,更大的风险在于,当我们忙着辩论虚构的未来心智如何对齐时,我们却忽视了现有制度的对齐问题。

事实是,除了技术变革本身是必然的之外,关于我们技术未来的任何事情都不是必然的。变化是确定的,但其方向却未必。我们尚未理解自己正在构建什么样的系统,或者它们将产生怎样的,突破与失败相互交织的未来。这种不确定性使得将公共资源和注意力孤注一掷于单一的推测性路径,显得尤为鲁莽。

每一个算法都蕴含着关于价值和受益者的选择。超级智能的叙事试图用宿命的薄纱掩盖这些抉择,但替代性的想象——原生治理、工人主导的设计、女性主义与残障正义、基于公共领域的AI模式以及生态约束却提醒我们,其他路径是可能的,并且已经在构建之中。

真正的政治问题,不是某种人工超级智能是否会涌现,而是谁有权决定我们构建和维持何种智能?答案不能留给那些宣扬“人工超越,世界灭亡”的企业先知,因为AI的未来是一个政治场域,它应该开放给各种观点加以争论。它不属于那些以最大声警告神明或怪物的人,而应属于那些拥有道德权利,能够通过民主治理塑造他们生活的技术的公众。

09

译者的话

在最近一年中,你有多少次听到超级智能,对齐的讨论,在你看到那些大佬们预测2027年即将降临的超级智能时,是否忘记了一个基本事实:我们至今仍不知道如何制造一个超级智能,一切关于它的讨论,本质上都是建立在沙堆之上的假设。

这篇长文揭示了一种人类历史中少见的现象。当卖伞的人拥有了人工降雨的能力,我们是否应当对他们兜售雨伞的动机保持警惕?工业革命时,工厂主不会说会有一种将要取代一切劳动力的机器,以此劝诱工人“现在苦一苦,好日子就在后头”。正是由于缺少对乌托邦未来的想象,工人们才为了自己的权益争取,才有了如今的五一劳动节。

晚期资本主义的可怕,在于其对思想的隐性控制是潜移默化的,是通过议题设置,偷换概念等手段完成的。当OpenAI不再开源,当科技巨头为了曝光,而发布的关于超级智能,AI安全等研究时,我们不应当遗忘那些持续承诺开源的中国企业,那些关注AI在具体场景中应用的小微甚至个人开发者。

当西方主流叙事将超级智能描绘成《指环王》中的至尊魔戒,能够掌管一切时,我们不应当无条件的遵循,而应替人类去探索另一条基于本体,立足场景的全新AI应用之路。谨以此作为翻译这篇长文的初心与愿景。

原文链接:

https://www.noemamag.com/the-politics-of-superintelligence/

转载请注明:好奇网 » AI、AI、AI,一天到晚都是AI,这背后是不是有什么阴谋?