苹果公司的最新论文指出:大模型的思考就像拿假身份证进网吧,灯一照就原形毕露。遇到高难度任务时,不管 ChatGPT、Claude 还是 DeepSeek,统统卡死。

国外网友嘲笑苹果:你弄不出AI,现在你来挖苦别人…

一分钟看懂论文核心

- 论文标题:《The Illusion of Thinking》(2025 年 6 月)

- 主笔阵容:Apple AI 研究院 + Samy Bengio(谷歌大脑联合创始人)。

- 关键发现:当前所谓“会推理”的大模型,其实都在“假装思考”。

- 现实意义:未来评价模型不能只看答对没,要检查它每一步究竟在干啥。

原来我天天用的推理模型,其实是一只记忆力超群的鹦鹉而已。

四道智力题,把大模型逼疯了

苹果没有用通用测试数据,而是亲自设计了四种经典的“智力题”作为测试,避免大模型已经学习过。

并且每道题目都可以精确调节难度,就像打游戏时能设难度级别一样:

- 汉诺塔(Tower of Hanoi):考验多步规划与耐心

- 跳棋交换(Checker Jumping):考察路径搜索与位置感知

- 过河问题(River Crossing):需要逻辑约束与安全规则理解

- 积木世界(Blocks World):考验空间变换与任务还原能力

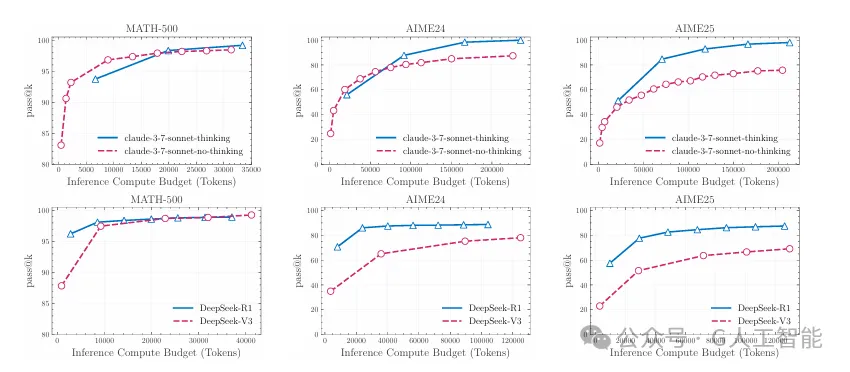

苹果在这些任务中测试了 Claude 3.7 Sonnet、DeepSeek R1、o3-mini 等推理模型。结果出现了一种极其讽刺的现象:

- 低难度时:传统语言模型(没思考)表现更好!

- 中等复杂度:长链推理模型开始发力,“思考”帮了一点忙。

- 高复杂度时:不管思不思考,全军崩盘,准确率归零。

更魔幻的是:模型在“越难越该思考”的时刻,反而主动减少推理,像是突然佛系了…

我一度以为是内存出错,结果看实验数据才明白——这不是bug,这是它们的“默认逃避机制”。

模型并不理解:自己在做什么

论文中最惊人的实验是:研究者直接把解题步骤写在提示词里,告诉模型“怎么一步步做”。

结果呢?它们还是错。准确率并没有提高太多。

这就像告诉一个人“先走三步,再右转”,结果他原地打转三圈跳进水坑里。

Claude 3.7:会搬汉诺塔,却连河都过不了

这明显不是能力问题,而是训练偏差。因为互联网上汉诺塔教程满天飞,Claude见多了,而过河问题?冷门题材,没刷到自然不会。

- 在汉诺塔N=5(要走31步)中几乎完美,只在100步后出错;

- 但在过河问题N=3(仅需11步)中,前四步就崩了。

这点我特别有共鸣。有一次我用 Claude 解“灯泡三开关”逻辑题,它连题意都理解错,最后靠猜给了个答案,还信誓旦旦说对。

苹果这是“酸葡萄”行为吗?

不少网友质疑:苹果两年AI没啥建树,现在靠发论文来嘲讽同行?确实,苹果AI最近风评不佳:

- 去年发布的Apple Intelligence多项功能被砍

- Siri新版本连续跳票,被苹果内部戏称为“AI幽灵”

- 个性化表情Genmoji因发热严重被下架

但这篇论文其实并不“酸”。它不是在说“别家不行”,而是提出了一个新的行业共识:

✅ 只看结果对错,无法衡量AI是否真的“会推理”。

✅ 应该评估中间步骤的“合理性、节奏和逻辑连贯度”。

这一点,很可能会引导行业开发出新一代的AI评估体系。

竞争对手们在做什么?

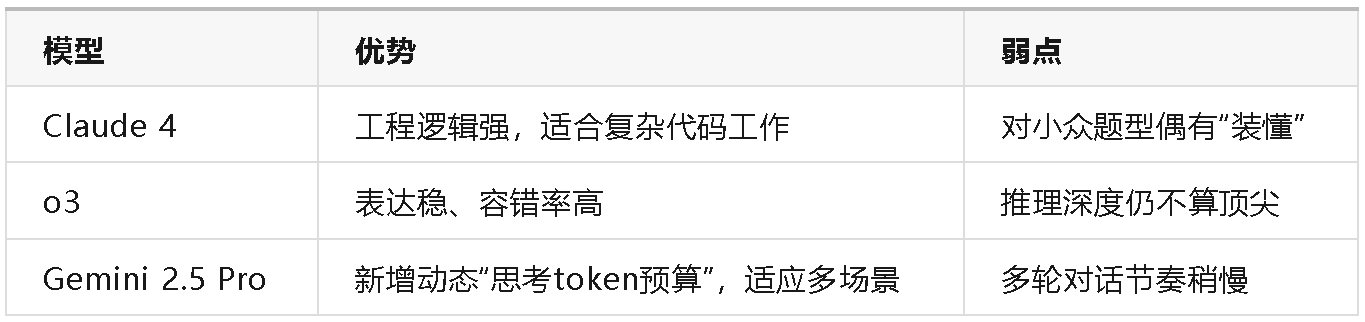

苹果论文没直接点名 o3、Claude 4、Gemini 2.5 Pro,但我们从公开数据能看出一些趋势:

这些模型虽然比2023年的产品强太多,但在“长链逻辑”领域,也都未能彻底突破。

别说“像人类一样推理”,目前它们连“像小学生一样不走神”都做不到。

我作为 AI 内容创作者,别再幻想“AI 已经会思考了”

这篇论文给了我一个重锤:它们是在演我们——用token堆砌模式,假装懂你,其实啥也没内化,我们高估了它们的“理解力”。

苹果提出的建议其实蛮有建设性:

- 要构建过程导向型测试集,看模型每一步有没有绕弯路;

- 不能只测“对错”,要测“怎么对的”;

- 模型token预算不能越用越“佛”,应有动态思考分配机制。

这对未来AI系统尤其关键——比如无人驾驶、金融决策、医疗问诊,如果模型只是“套模板”,那可不是翻车,是砸锅!

你还相信 AI 会思考吗?

🤯 它们根本不懂,只是高仿装模作样

😐 不用懂,能干活就行

🔮 真正通用智能,很快就来了

原论文地址:https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf