吹智能体的都是没用过的。

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:很多预测都认为今年是智能体爆发之年。但一位博主用自己的亲身实践指出,AI的不确定性是很大的麻烦,智能体不大可能接管关键的业务流程。文章来自编译。

每次上 LinkedIn ,我总免不了会看到有产品经理大肆宣传智能体“就快到来”。

早在 ChatGPT 之前,大语言模型(LLM)我一直都在用,那时候还是 OpenAI 网站上的 GPT-3,只能预测一句话的下一个单词是什么(而不是现在大家熟悉的聊天界面)。

我从零开始开发AI应用,训练各种类型的AI模型。我在拥有全球最好的AI与计算机科学学院的卡内基梅隆大学学习了深度学习课程,并获得了硕士学位。

可当我又刷到一个TikTok视频时,我不仅思考起“Web 3 将如何改变互联网”来。

我发誓,这肯定是机器人农场、不懂技术的人还有 OpenAI 制造的炒作,为的是能挣到更多的钱。我换个方式解释吧,你知道发布了可用于生产的智能体软件工程师有多少吗?

没错,一个都没有。

所以说这一切的人为炒作都是无稽之谈。

什么是“AI智能体”?

其实智能体在人工智能领域有着悠久的历史。自 ChatGPT 发明的近年来,智能体的意思演变成结构可进行推理并自主完成任务的大语言模型。

这种模型可能可以通过强化学习进行微调,但在实践中大家一般只用 OpenAI 的 GPT、Google Gemini 或 Anthropic 的 Claude。

智能体与语言模型的区别在于智能体可以自主完成任务。

这里有个例子。

我有个算法交易和金融研究平台, NexusTrade 。

假设我不想在付钱给外部数据提供商来获取美国公司的基本数据了。

用传统的语言模型,我得编写跟它们交互的代码。大概是这样的:

- 先写个脚本抓取 SEC 网站信息,或用 GitHub 库获取公司信息

- 用pypdf等 Python 库将 PDF 转换为文本

- 发送给大语言模型格式化数据

- 对响应进行验证

- 将数据保存进数据库

- 对各家公司重复此操作

如果有AI智能体的话,理论上你就只需要说就行了。

抓取各家美国公司过去和未来的历史数据,并将其保存到 MongoDB 数据库中

也许它会要求你一些澄清问题。它可能会问你一些抓取的条件,或者哪些信息最重要。

但思路是你给它一个目标,它就会完全自主地完成任务。

听起来好得令人难以置信,对吧?

因为确实如此。

AI智能体的实际问题

如果最便宜的小语言模型是免费的,且跟 Claude 3.5 一样强大,还可以在任何 AWS T2 实例本地运行的话,那这篇文章的基调就完全不同了。

这不是要指责什么,而是一个警告。

就目前情况而言,AI智能体在现实世界是没法用的,原因如下。

1. 小模型远远不够强大

智能体的核心问题是要依赖大语言模型。

说得更具体一点,要靠有个好模型。

GPT-4o mini,除了 Flash 之外最便宜的大语言模型,价格确实令人惊叹。

但功能还不够强大,没法完成现实世界的智能体任务。

不管你怎么提示,它都会偏离目标,忘记目标,或者犯一些很简单的错误。

如果本地部署的话,企业会付出代价。大语言模型一旦出错,除非你自己开发了(也许是基于 LLM 的)验证框架,否则是很难检测的。一开始只是一个小错误,但之后的所有错误都会被掩盖。

实际上大概是下面这样的。

2. 错上加错

假设你在用 GPT-4o-mini 执行智能体工作。

你的智能体将提取公司财务信息的任务分解为更小的子任务。假设它正确完成每个子任务的概率为 90%。

叠加之下,最后的错误会很严重。即使是一个难度适中的任务,比方说包含四个子任务,最终输出好结果的概率也非常低。

比方说,如果任务分解如下:

完成一个子任务的概率是90%

两个子任务执行正确的概率就变成0.9*0.9 = 81%

而四个子任务均执行正确的概率为 66%

发现问题了吗?

要想缓解这种情况,你得采用更好的语言模型。更强大的模型可能可以将每个子任务的完成准确率提高到 99%。执行完四个子任务后,最终的准确率可达 96%。好多了(但仍然不完美)。

最重要的是,如果使用这些更强大的模型会导致成本激增。

3. 成本激增

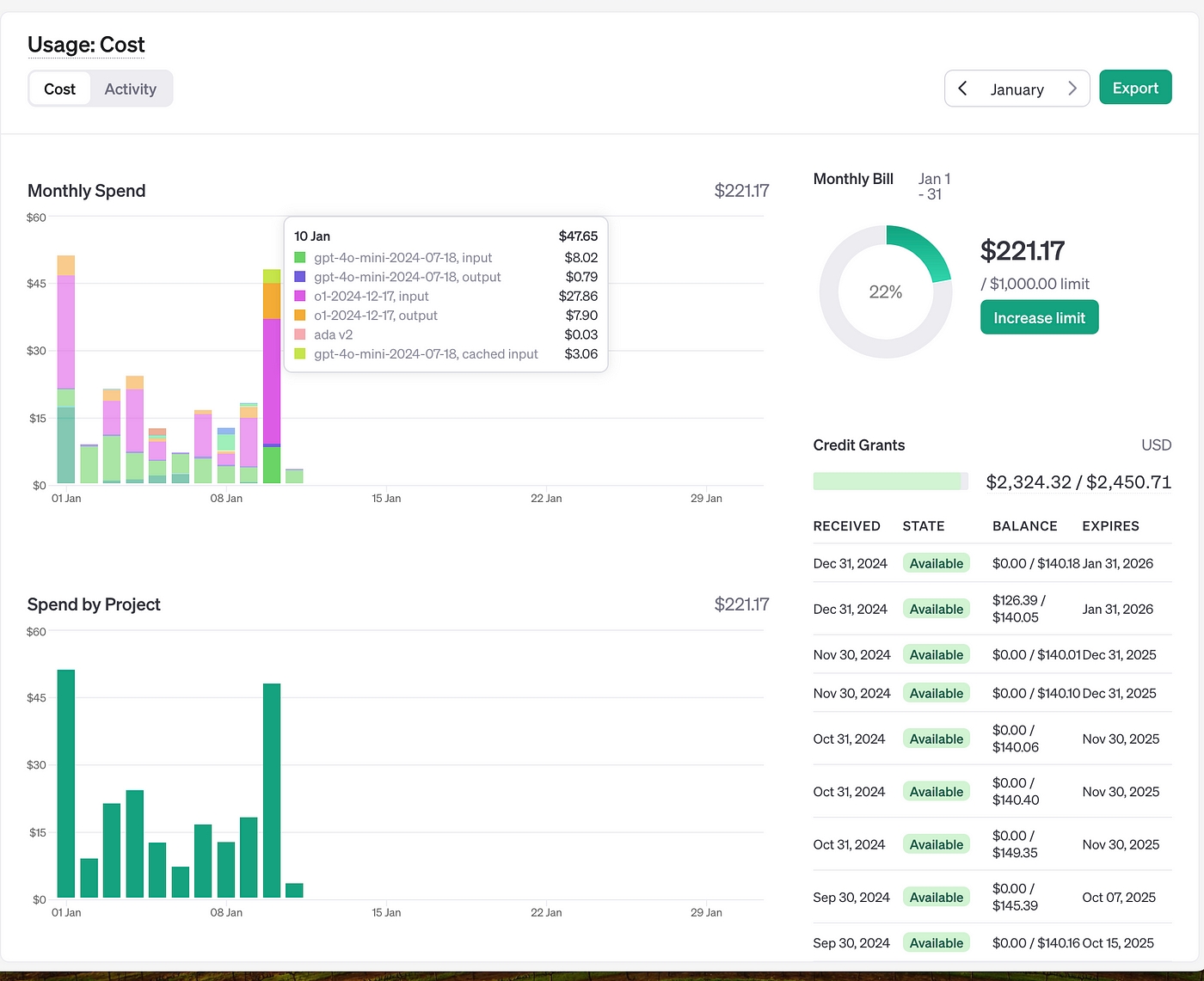

OpenAI 的 o1 模型与 GPT-4o-mini 之间的成本差异

OpenAI 的 o1 模型与 GPT-4o-mini 之间的成本差异

一旦你切换到更强大的 OpenAI 模型,你就会看到你的成本如何爆炸式增长。

粉色和橙色线是 OpenAI o1 的成本。我可能每天会用 4-5 次,用来执行极其繁重的任务,比方说为股票分析生成语法有效的查询。

浅绿色和深蓝色的线是 GPT-4o-mini。这个模型每天都会收到数百个请求,最终成本只占 o1 成本的一小部分。

此外,即便如此,你还是得验证最终的输出。出于同样的原因,你得用更强大的模型进行验证。

也就是说,你可以用更大的模型作为智能体,并用更大的模型进行验证。

知道我为什么认为这就是 OpenAI 的阴谋了吧?

最后,让世界从使用代码变为使用模型会产生巨大副作用。

4. 你做出来的东西会有不确定性

在采用 LLM 智能体的情况下,整个工作范式会变成数据科学法。

现在不是编写在任何地方跑都不贵且在arduino 上也可以跑起来的具备确定性的代码了,而是要给在 GPU 集群上的跑模型写有不确定性的提示了。

如果“幸运”的话,你也许能在自己的 GPU 上跑自己微调的模型,但光是维护智能体来执行简单任务仍然要花你一大笔钱。

如果不幸的话,你会完全被OpenAI锁定;如果你想换个模型,你的提示就会完全失效,而且当你用他们的 API 去跑关键业务流程时,他们会慢慢提高价格。

先别着急说“用OpenRouter就可以轻松切换模型”,再想一想看。Anthropic 模型的输出跟 OpenAI 的输出是不一样的。

所以,你得重新设计整个技术栈,花费一大笔钱,就为了让另一个 LLM 提供商的最终表现有一点点改善。

看出问题是什么了吗?

结论

所以我以看到有关智能体的帖子时,几乎可以肯定那是没用过语言模型的人写的。

我的意思不是AI没用武之地。即便是智能体,几年后也能用,可以帮工程师写些简单的代码。

但是,没有哪家公司会用一套极其昂贵且容易出错的智能体来取代他们的运营团队,去跑业务的关键流程。

谁要是敢试一下,两年内必破产。他们将成为商业教科书的失败案例,而 OpenAI 则又有10 亿美元进账。

记住我的话。

译者:boxi。

转载请注明:好奇网 » 追捧“AI智能体”的人该醒醒了